ProxCLMC – Was ist das?

Live-Migration ist eine der leistungsfähigsten und am häufigsten genutzten Funktionen in einem Proxmox VE Cluster. Sie setzt jedoch eine Voraussetzung voraus, die oft unterschätzt wird: eine konsistente CPU-Kompatibilität über alle Nodes hinweg. In realen Umgebungen bestehen Cluster selten aus identischer Hardware, bei der man einfach den CPU-Typ host verwenden könnte. Nodes werden über die Zeit hinweg hinzugefügt, CPU-Generationen unterscheiden sich und Funktionsumfänge entwickeln sich weiter. Obwohl Proxmox VE eine flexible CPU-Konfiguration erlaubt, ist die Ermittlung einer sicheren und zugleich optimalen CPU-Baseline für den gesamten Cluster bislang weitgehend eine manuelle und erfahrungsbasierte Aufgabe.

ProxCLMC (Prox CPU Live Migration Checker) wurde von unserem Kollegen Florian Paul Azim Hoberg (auch bekannt als gyptazy) in Rust als Open-Source Lösung unter der GPLv3 Lizenz entwickelt, um diese Lücke auf einfache, automatisierte und reproduzierbare Weise zu schließen. Das Tool untersucht alle Nodes eines Proxmox-VE-Clusters, analysiert nachfolgend deren CPU-Fähigkeiten und berechnet das höchstmögliche CPU-Kompatibilitätsniveau, das von jedem Node unterstützt wird. Anstatt sich auf Annahmen, Tabellenkalkulationen oder Versuch und Irrtum zu verlassen, erhalten Administratoren ein klares und deterministisches Ergebnis, das direkt bei der Auswahl von VM-CPU-Modellen verwendet werden kann.

In anderen Virtualisierungsökosystemen existieren vergleichbare Mechanismen bereits. Enterprise-Plattformen bieten häufig integrierte Werkzeuge oder automatische Hilfestellungen, um kompatible CPU-Baselines zu erkennen und ungültige Live-Migrationskonfigurationen zu verhindern. Proxmox VE verfügt derzeit jedoch über keinen solchen automatisierten Erkennungsmechanismus, sodass Administratoren CPU-Flags manuell vergleichen oder sich auf Betriebserfahrung verlassen müssen. ProxCLMC schließt diese Lücke, indem es eine clusterweite CPU-Kompatibilitätsanalyse bereitstellt, die speziell auf Proxmox-Umgebungen zugeschnitten ist.

Wie funktioniert ProxCLMC?

ProxCLMC ist so konzipiert, dass es sich nahtlos in bestehende Proxmox-VE-Cluster integrieren lässt, ohne zusätzliche Dienste, Agents oder Konfigurationsänderungen zu erfordern. Es ist vollständig in Rust geschrieben (vollständig Open Source unter GPLv3), wird als statisches Binary kompiliert und als Debian-Paket über das gyptazy-Repository bereitgestellt, um eine einfache Installation zu ermöglichen. Der Arbeitsablauf folgt einem klaren und transparenten Prozess, der widerspiegelt, wie Administratoren über CPU-Kompatibilität nachdenken, diesen jedoch zuverlässig und reproduzierbar automatisiert.

Nach dem Start parst das Tool die lokale corosync.conf auf dem Node, auf dem es ausgeführt wird. Dadurch kann ProxCLMC automatisch alle Mitglieder des Clusters erkennen, ohne auf externe Inventare oder manuelle Eingaben angewiesen zu sein. Die ermittelte Node-Liste entspricht somit stets dem tatsächlichen Zustand des Clusters.

Sobald alle Cluster-Nodes identifiziert sind, baut ProxCLMC eine SSH-Verbindung zu jedem Node auf. Über diese Verbindung liest es remote den Inhalt von /proc/cpuinfo. Diese Datei liefert eine detaillierte und maßgebliche Sicht auf die vom Host-Kernel bereitgestellten CPU-Fähigkeiten, einschließlich des vollständigen Satzes unterstützter CPU-Flags.

Aus den gesammelten Daten extrahiert ProxCLMC die relevanten CPU-Flags und wertet sie anhand klar definierter x86-64-CPU-Baseline-Definitionen aus. Diese Baselines sind direkt an die von Proxmox VE und QEMU unterstützten CPU-Modelle angelehnt, darunter:

- x86-64-v1

- x86-64-v2-AES

- x86-64-v3

- x86-64-v4

Durch die Zuordnung der CPU-Flags jedes Nodes zu diesen standardisierten Baselines kann ProxCLMC bestimmen, welche CPU-Level pro Node unterstützt werden. Anschließend berechnet das Tool den niedrigsten gemeinsamen CPU-Typ, der von allen Nodes im Cluster geteilt wird. Diese resultierende Baseline stellt das maximale CPU-Kompatibilitätsniveau dar, das sicher für virtuelle Maschinen verwendet werden kann und dennoch uneingeschränkte Live-Migrationen zwischen allen Nodes ermöglicht. Um eine allgemeine Vorstellung von der Ausgabe zu bekommen:

test-pmx01 | 10.10.10.21 | x86-64-v3

test-pmx02 | 10.10.10.22 | x86-64-v3

test-pmx03 | 10.10.10.23 | x86-64-v4

Cluster CPU type: x86-64-v3

Mit diesem Ansatz bringt ProxCLMC eine automatisierte CPU-Kompatibilitätsprüfung in Proxmox-VE-basierte Cluster. Vergleichbare Konzepte sind aus anderen Virtualisierungsplattformen bereits bekannt, etwa VMware EVC, bei dem die CPU-Kompatibilität clusterweit erzwungen wird, um sichere Migrationen zu gewährleisten. ProxCLMC überträgt diese grundlegende Idee auf Proxmox-Umgebungen, setzt sie jedoch leichtgewichtig, transparent und vollständig offen um und fügt sich damit nahtlos in bestehende Betriebs- und Arbeitsabläufe ein.

Installation von ProxCLMC

ProxCLMC wurde mit dem Ziel entwickelt, eine einfache Bereitstellung zu ermöglichen und sich sauber in bestehende Proxmox-VE-Umgebungen zu integrieren. Es kann direkt aus dem Quellcode genutzt oder als paketiertes Debian-Binary installiert werden und eignet sich damit sowohl für Entwicklungs- als auch für Produktionsumgebungen.

Der vollständige Quellcode ist öffentlich auf GitHub verfügbar und kann unter folgender Adresse abgerufen werden:

https://github.com/gyptazy/ProxCLMC

Dies ermöglicht vollständige Transparenz, Auditierbarkeit sowie die Möglichkeit, das Tool an individuelle Anforderungen anzupassen oder selbst zu bauen.

Voraussetzungen und Abhängigkeiten

Vor der Installation von ProxCLMC müssen folgende Voraussetzungen erfüllt sein:

- Ein Proxmox-VE-Cluster

- SSH-Authentifizierung zwischen allen Proxmox-VE-Nodes

- Netzwerkverbindung zwischen allen Cluster-Mitgliedern

ProxCLMC nutzt SSH, um jeden Node remote zu untersuchen und CPU-Informationen auszulesen. Eine passwortlose SSH-Authentifizierung wird daher empfohlen, um eine reibungslose und automatisierte Ausführung zu gewährleisten.

Installation über das Debian-Repository

Der empfohlene Weg zur Installation von ProxCLMC auf Debian-basierten Systemen, einschließlich Proxmox VE, ist über das von gyptazy bereitgestellte Debian-Repository. Dieses Repository wird auch zur Distribution des ProxLB-Projekts genutzt und fügt sich nahtlos in die üblichen Paketmanagement-Workflows ein.

Um das Repository hinzuzufügen und ProxCLMC zu installieren, führen Sie die folgenden Befehle aus:

Die Nutzung des Repositories stellt sicher, dass ProxCLMC einfach installiert, aktualisiert und gemeinsam mit anderen Systempaketen verwaltet werden kann.

Installation über ein Debian-Paket

Alternativ kann ProxCLMC auch manuell über ein vorgebautes Debian-Paket installiert werden. Dies ist besonders nützlich für Umgebungen ohne direkten Repository-Zugriff oder für Offline-Installationen.

Das Paket kann direkt über das CDN von gyptazy heruntergeladen und mit dpkg installiert werden:

Diese Methode bietet den gleichen Funktionsumfang wie die Installation über das Repository, jedoch ohne automatische Updates.

Fazit

ProxCLMC zeigt exemplarisch, wie schnell Lücken im Open-Source-Virtualisierungsökosystem geschlossen werden können, wenn reale betriebliche Anforderungen direkt adressiert werden. Ähnlich wie das ProxLB-Projekt (GitHub), das erweiterte Scheduling- und Balancing-Funktionen für Proxmox-VE-basierte Cluster bereitstellt, konzentriert sich ProxCLMC auf einen sehr spezifischen, aber kritischen Bereich, der zuvor weitgehend manuellen Prozessen und Erfahrungswerten überlassen war.

Durch die Einführung einer automatisierten CPU-Kompatibilitätserkennung bringt ProxCLMC eine Funktionalität in Proxmox-VE-Cluster, die in Enterprise-Virtualisierungsplattformen üblicherweise erwartet wird, bislang jedoch nicht in automatisierter Form verfügbar war. Es zeigt, dass Open-Source-Lösungen nicht durch fehlende Funktionen begrenzt sind, sondern vielmehr die Freiheit bieten, Plattformen genau dort zu erweitern und anzupassen, wo es am wichtigsten ist.

Mit ProxCLMC können Betreiber nun automatisch den am besten geeigneten CPU-Typ für virtuelle Maschinen in einem Proxmox-VE-Cluster ermitteln und so sichere Live-Migrationen sowie ein konsistentes Verhalten über alle Nodes hinweg gewährleisten. Zusammen mit Projekten wie ProxLB unterstreicht dies die Stärke des Open-Source-Modells: fehlende Enterprise-Funktionen können transparent ergänzt, an reale Anforderungen angepasst und mit der Community geteilt werden, um das Proxmox-Ökosystem kontinuierlich zu verbessern. Sollte Sie ebenfalls Bedarf an weiteren Anpassungen oder Entwicklungen Rund um oder für Proxmox VE benötigen, so unterstützten wir Sie gerne bei der Realisierung! Zögern Sie nicht mit uns Kontakt aufzunehmen – gerne beraten wir Sie zu Ihrem Vorhaben!

Automatisierte Proxmox-Abonnementverwaltung mit Ansible

Bei der Bereitstellung von Proxmox VE in Enterprise-Umgebungen, sei es für neue Standorte, die Erweiterung bestehender Cluster oder die Migration von Plattformen wie VMware, ist Automatisierung unerlässlich. Diese Szenarien umfassen typischerweise die Bereitstellung von Dutzenden oder sogar Hunderten von Knoten über mehrere Standorte hinweg. Das manuelle Aktivieren von Abonnements über die Proxmox-Weboberfläche ist in diesem Umfang nicht praktikabel.

Um Konsistenz und Effizienz zu gewährleisten, sollte jeder Teil des Bereitstellungsprozesses von Anfang an automatisiert werden. Dies umfasst nicht nur die Installation und Konfiguration von Knoten, die automatisierte Cluster-Erstellung, sondern auch die Aktivierung des Proxmox-Abonnements. In der Vergangenheit erforderte dieser Schritt oft eine manuelle Interaktion, was die Bereitstellung verlangsamte und unnötige Komplexität verursachte.

Jetzt gibt es eine saubere Lösung dafür. Mit der Einführung des neuen Ansible-Moduls proxmox_node ist die Abonnementverwaltung vollständig integriert. Dieses Modul ermöglicht es Ihnen, die Abonnementaktivierung als Teil Ihrer Ansible-Playbooks zu handhaben, wodurch es möglich wird, den gesamten Prozess zu automatisieren, ohne jemals die Weboberfläche öffnen zu müssen.

Diese Verbesserung ist besonders wertvoll für Massenbereitstellungen, bei denen Zuverlässigkeit und Wiederholbarkeit am wichtigsten sind. Jeder Knoten kann nun direkt nach dem Booten automatisch konfiguriert, lizenziert und produktionsbereit sein. Es ist ein großartiges Beispiel dafür, wie sich Proxmox VE kontinuierlich zu einer unternehmensfreundlicheren Plattform entwickelt und gleichzeitig die Flexibilität und Offenheit beibehält, die es auszeichnet.

Ansible-Modul: proxmox_node

Da die Automatisierung in modernen IT-Betrieben immer wichtiger wird, ist die Verwaltung der Proxmox VE-Infrastruktur über standardisierte Tools wie Ansible zu einer gängigen Praxis geworden. Bis jetzt, obwohl verschiedene Community-Module zur Interaktion mit Proxmox-Ressourcen verfügbar waren, erforderte die Knotenverwaltung oft benutzerdefinierte Workarounds oder direkten SSH-Zugriff. Diese Lücke wurde nun mit der Einführung des neuen proxmox_node Moduls geschlossen.

Dieses Modul wurde von unserem Team bei credativ GmbH entwickelt, insbesondere von unserem Kollegen, der in der Community unter dem Handle gyptazy bekannt ist. Es wurde Upstream beigetragen und ist bereits Teil der offiziellen Ansible Community Proxmox Collection, die jedem zur Verfügung steht, der die Collection über Ansible Galaxy oder Automation Controller Integrationen verwendet.

Das proxmox_node Modul konzentriert sich auf Aufgaben, die direkt mit dem Lebenszyklus und der Konfiguration eines Proxmox VE-Knotens zusammenhängen. Was dieses Modul besonders leistungsfähig macht, ist, dass es direkt mit der Proxmox API interagiert, ohne dass ein SSH-Zugriff auf den Knoten erforderlich ist. Dies ermöglicht einen saubereren, sichereren und API-gesteuerten Ansatz zur Automatisierung.

Das Modul unterstützt derzeit mehrere Schlüsselfunktionen, die im realen Betrieb unerlässlich sind:

- Verwaltung von Abonnementlizenzen

Eine der herausragenden Funktionen ist die Möglichkeit, einen Proxmox VE-Abonnementschlüssel automatisch hochzuladen und zu aktivieren. Dies ist unglaublich hilfreich für Unternehmen, die Cluster in großem Umfang ausrollen, wo die Lizenzierung konsistent und automatisch als Teil des Bereitstellungs-Workflows gehandhabt werden sollte. - Steuerung der Leistungszustände

Die Energieverwaltung von Knoten kann nun über Ansible erfolgen, was es einfach macht, Knoten im Rahmen von Playbook-gesteuerten Wartungsaufgaben oder während automatisierter Clusteroperationen zu starten (über Wake-on-Lan) oder herunterzufahren.

- Verwaltung der DNS-Konfiguration

DNS-Einstellungen wie Resolver und Suchdomänen können deklarativ geändert werden, wodurch sichergestellt wird, dass alle Knoten die gleichen Konfigurationsrichtlinien ohne manuelle Eingriffe befolgen.

- Verwaltung von X509-Zertifikaten

Das Modul ermöglicht es Ihnen auch, die von dem Knoten verwendeten TLS-Zertifikate zu verwalten. Unabhängig davon, ob Sie intern PKI-signierte Zertifikate bereitstellen oder extern ausgestellte verwenden, können Sie mit demproxmox_nodeModul diese über die Automatisierung auf saubere und wiederholbare Weise hochladen und anwenden.

Indem all diese Funktionalität in einem einzigen, API-gesteuerten Ansible-Modul zusammengeführt wird, wird der Prozess der Verwaltung von Proxmox-Knoten wesentlich zuverlässiger und wartungsfreundlicher. Sie müssen nicht mehr mit Shell-Befehlen um pveproxy herumskripten oder SSH verwenden, nur um Knoteneinstellungen zu verwalten.

Beispiel für die Integration von Abonnements

Das Hinzufügen eines Abonnements zu einem Proxmox VE-Knoten ist so einfach wie die folgende Aufgabe. Dies zeigt zwar den einfachsten Weg für einen einzelnen Knoten, kann aber auch in einer Schleife über ein Dictionary verwendet werden, das die zugehörigen Abonnements für jeden Knoten enthält.

- name: Platzieren einer Abonnementlizenz auf einem Proxmox VE-Knoten community.proxmox.node: api_host: proxmoxhost api_user: gyptazy@pam api_password: password123 validate_certs: false node_name: de-cgn01-virt01 subscription: state: present key: ABCD-EFGH-IJKL-MNOP-QRST-UVWX-YZ0123456789

Fazit

Für uns bei credativ schließt dieses Modul eine echte Lücke in der Automatisierungslandschaft rund um Proxmox und demonstriert, wie fehlende Funktionen in Open-Source-Projekten durch Upstream-Beiträge effektiv angegangen werden können. Es verstärkt auch die breitere Bewegung der deklarativen Verwaltung von Infrastruktur, bei der die Konfiguration versioniert, dokumentiert und leicht reproduzierbar ist.

In Kombination mit anderen Modulen aus der Community Proxmox Collection wie unserem kürzlich erschienenen proxmox_cluster Modul, proxmox_node hilft, das Bild einer vollständig automatisierten Proxmox VE-Umgebung zu vervollständigen — von der Cluster-Erstellung und VM-Bereitstellung bis hin zur Knotenkonfiguration und Lizenzierung. Wenn Sie Hilfe oder Unterstützung bei der Erstellung von Proxmox VE-basierten Virtualisierungsinfrastrukturen, Automatisierung oder kundenspezifischer Entwicklung zur Anpassung an Ihre Bedürfnisse suchen, helfen wir Ihnen gerne weiter! Sie können uns jederzeit gerne kontaktieren.

Veeam & Proxmox VE

Veeam hat einen strategischen Schritt unternommen, indem es die Open-Source-Virtualisierungslösung Proxmox VE (Virtual Environment) in sein Portfolio integriert hat. Dies signalisiert sein Engagement für die sich entwickelnden Bedürfnisse der Open-Source-Community und des Open-Source-Virtualisierungsmarktes und positioniert Veeam als zukunftsorientierten Akteur in der Branche, der bereit ist, die wachsende Verbreitung von Open-Source-Lösungen zu unterstützen. Die Kombination von Veeams Datenschutzlösungen mit der Flexibilität der Proxmox VE-Plattform bietet Unternehmen eine überzeugende Alternative, die Kosteneinsparungen und verbesserte Datensicherheit verspricht.

Mit Proxmox VE wird nun auch eine der wichtigsten und oft angefragten Open-Source-Lösungen und Hypervisoren nativ unterstützt – und dies könnte definitiv eine Wende auf dem Virtualisierungsmarkt bedeuten!

Möglichkeiten für Open-Source-Virtualisierung

In vielen Unternehmen ist bereits eine wichtige Hypervisor-Plattform im Einsatz, begleitet von einer robusten Backup-Lösung – oft Veeam. Bislang fehlte Veeam jedoch die direkte Unterstützung für Proxmox VE, was eine Lücke für diejenigen hinterließ, die diese Open-Source-Virtualisierungsplattform nutzen oder in Betracht ziehen. Die neueste Version von Veeam ändert dies, indem sie die Möglichkeit bietet, Backups und Wiederherstellungen direkt in Proxmox VE-Umgebungen zu erstellen und zu verwalten, ohne dass Agenten innerhalb der VMs erforderlich sind.

Diese Weiterentwicklung bedeutet, dass nun ganze VMs über jeden Hypervisor hinweg gesichert und wiederhergestellt werden können, was eine beispiellose Flexibilität bietet. Darüber hinaus können Unternehmen einen neuen Proxmox VE-basierten Cluster nahtlos in ihre bestehende Veeam-Einrichtung integrieren und alles von einem einzigen, zentralen Punkt aus verwalten. Diese Integration vereinfacht Abläufe, reduziert die Komplexität und verbessert die Gesamteffizienz von Datenschutzstrategien in Umgebungen mit mehreren Hypervisoren, indem einfach eine All-in-One-Lösung vorhanden ist.

Ein ebenfalls stark unterschätzter Vorteil sind die Möglichkeiten, ganze VMs einfach zu migrieren, zu kopieren, zu sichern und wiederherzustellen, selbst unabhängig von ihrem zugrunde liegenden Hypervisor – auch bekannt als Cross-Platform-Recovery. Dadurch können Administratoren VMs nun von VMware ESXi-Knoten / vSphere oder Hyper-V auf Proxmox VE-Knoten verschieben. Dies bietet eine hervorragende Lösung, um eine neue Virtualisierungsplattform risikofrei einzuführen und zu bewerten. Für Unternehmen, die ihre Virtualisierungs- und Backup-Infrastruktur vereinheitlichen möchten, stellt dieses Update einen bedeutenden Fortschritt dar.

Integration in Veeam

Die Integration eines neuen Proxmox-Clusters in eine bestehende Veeam-Umgebung ist ein Beweis für die Einfachheit und das benutzerzentrierte Design beider Systeme. Wer mit Veeam vertraut ist, wird den Prozess als intuitiv und minimal störend empfinden, was eine nahtlose Erweiterung der Virtualisierungsumgebung ermöglicht. Diese einfache Integration bedeutet, dass Ihr neuer Proxmox VE-Cluster schnell unter den schützenden Schirm der robusten Backup- und Replikationsdienste von Veeam gebracht werden kann.

Trotz der allgemeinen Einfachheit des Prozesses ist es wichtig zu erkennen, dass einzigartige Konfigurationen und spezifische Umgebungen ihre eigenen Herausforderungen mit sich bringen können. Diese Sonderfälle sind zwar nicht häufig, aber erwähnenswert, da sie besondere Aufmerksamkeit erfordern können, um eine reibungslose Integration zu gewährleisten. Seien Sie jedoch versichert, dass dies lediglich Nuancen in einem ansonsten unkomplizierten Verfahren sind und selbst diese mit etwas zusätzlicher Sorgfalt effektiv verwaltet werden können.

Übersicht

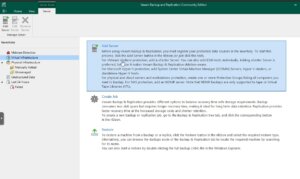

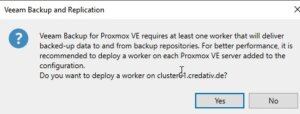

Ab Version 12.2 wird die Proxmox VE-Unterstützung durch ein Plugin aktiviert und integriert, das auf dem Veeam Backup-Server installiert wird. Veeam Backup für Proxmox verfügt über eine verteilte Architektur, die den Einsatz von Worker-Nodes erfordert. Diese Nodes funktionieren analog zu Data Movern und erleichtern die Übertragung von Virtual-Machine-Payloads von den Proxmox VE-Hosts zum vorgesehenen Backup-Repository. Die Worker laufen auf einer Linux-Plattform und werden nahtlos über die Veeam Backup Server-Konsole instanziiert. Ihre Rolle ist entscheidend und ähnelt der von Proxy-Komponenten in analogen Systemen wie AHV- oder VMware-Backup-Lösungen.

Ein solcher Worker wird mindestens einmal in einem Cluster benötigt. Für eine verbesserte Leistung könnte ein Worker pro Proxmox VE-Node in Betracht gezogen werden. Jeder Worker benötigt 6 vCPU, 6 GB Arbeitsspeicher und 100 GB Festplattenspeicher, was berücksichtigt werden sollte.

Anforderungen

Dieser Blogbeitrag geht davon aus, dass eine bereits vorhandene Installation von Veeam Backup & Replication in Version 12.2 oder höher bereits vorhanden und für eine andere Umgebung wie VMware vollständig konfiguriert ist. Es wird auch davon ausgegangen, dass der Proxmox VE-Cluster bereits vorhanden ist und Anmeldeinformationen mit den erforderlichen Rollen zur Durchführung der Backup-/Wiederherstellungsaktionen vorliegen.

Konfiguration

Die Integration und Konfiguration eines Proxmox VE-Clusters kann vollständig innerhalb der Veeam Backup & Replication Console-Anwendung erfolgen und erfordert keine zusätzlichen Befehle auf einer CLI. Die zuvor erwähnten Worker-Nodes können vollautomatisch installiert werden.

Hinzufügen eines Proxmox-Servers

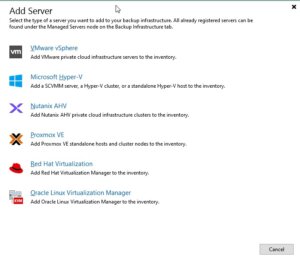

Um einen neuen Proxmox-Server in die Veeam Backup & Replication-Umgebung zu integrieren, muss man den Prozess durch Zugriff auf die Veeam-Konsole initiieren. Anschließend navigieren Sie durch die dafür vorgesehenen Abschnitte, um die Hinzufügung abzuschließen:

Um einen neuen Proxmox-Server in die Veeam Backup & Replication-Umgebung zu integrieren, muss man den Prozess durch Zugriff auf die Veeam-Konsole initiieren. Anschließend navigieren Sie durch die dafür vorgesehenen Abschnitte, um die Hinzufügung abzuschließen:

Virtuelle Infrastruktur -> Server hinzufügen

Dieses Verfahren entspricht dem etablierten Protokoll zur Einbindung von Nodes anderer Virtualisierungsplattformen, die mit Veeam kompatibel sind.

Anschließend zeigt Veeam Ihnen eine Auswahl möglicher und unterstützter Hypervisoren:

- VM vSphere

- Microsoft Hyper-V

- Nutanix AHV

- RedHat Virtualization

- Oracle Virtualization Manager

- Proxmox VE

In diesem Fall wählen wir einfach Proxmox VE und fahren mit dem Einrichtungsassistenten fort.

In den nächsten Schritten des Einrichtungsassistenten müssen die Authentifizierungsdetails, der Hostname oder die IP-Adresse des Ziel-Proxmox VE-Servers sowie ein Snapshot-Speicher des Proxmox VE-Servers definiert werden.

Hinweis: Bei den Authentifizierungsdetails achten Sie darauf, funktionierende Anmeldeinformationen für den SSH-Dienst auf dem Proxmox VE-Server zu verwenden. Wenn Sie normalerweise die root@pam-Anmeldeinformationen für die Weboberfläche verwenden, müssen Sie Veeam einfach die root-Anmeldeinformationen bereitstellen. Veeam initiiert eine Verbindung zum System über das SSH-Protokoll.

In einem der letzten Schritte des Einrichtungsassistenten bietet Veeam an, den erforderlichen Worker-Node automatisch zu installieren. Ein solcher Worker-Node ist eine kleine VM, die innerhalb des Clusters auf dem Ziel-Proxmox VE-Server läuft. Im Allgemeinen ist ein einzelner Worker-Node für einen Cluster ausreichend, aber zur Verbesserung der Gesamtleistung wird ein Worker pro Node empfohlen.

In einem der letzten Schritte des Einrichtungsassistenten bietet Veeam an, den erforderlichen Worker-Node automatisch zu installieren. Ein solcher Worker-Node ist eine kleine VM, die innerhalb des Clusters auf dem Ziel-Proxmox VE-Server läuft. Im Allgemeinen ist ein einzelner Worker-Node für einen Cluster ausreichend, aber zur Verbesserung der Gesamtleistung wird ein Worker pro Node empfohlen.

Nutzung

Sobald der Proxmox VE-Server erfolgreich in das Veeam-Inventar integriert wurde, kann er so mühelos verwaltet werden wie jeder andere unterstützte Hypervisor, wie VMware vSphere oder Microsoft Hyper-V. Ein wesentlicher Vorteil, wie im Screenshot gezeigt, ist die Möglichkeit, verschiedene Hypervisoren und Server in Clustern zentral zu administrieren. Dies eliminiert die Notwendigkeit einer separaten Veeam-Instanz für jeden Cluster und optimiert die Abläufe. Dennoch kann es spezifische Szenarien geben, in denen individuelle Setups für jeden Cluster vorzuziehen sind.

Sobald der Proxmox VE-Server erfolgreich in das Veeam-Inventar integriert wurde, kann er so mühelos verwaltet werden wie jeder andere unterstützte Hypervisor, wie VMware vSphere oder Microsoft Hyper-V. Ein wesentlicher Vorteil, wie im Screenshot gezeigt, ist die Möglichkeit, verschiedene Hypervisoren und Server in Clustern zentral zu administrieren. Dies eliminiert die Notwendigkeit einer separaten Veeam-Instanz für jeden Cluster und optimiert die Abläufe. Dennoch kann es spezifische Szenarien geben, in denen individuelle Setups für jeden Cluster vorzuziehen sind.

Dadurch wird nicht nur die Arbeit des Administrators bei der Arbeit mit verschiedenen Servern und Clustern vereinfacht, sondern bietet endlich auch die Möglichkeit für Cross-Hypervisor-Wiederherstellungen.

Backup-Jobs erstellen

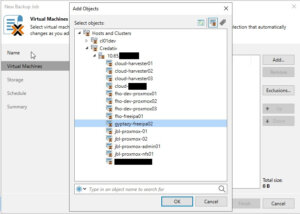

Das Erstellen eines neuen Backup-Jobs für eine einzelne VM oder sogar mehrere VMs in einer Proxmox-Umgebung ist so einfach und genau dasselbe, wie Sie es bereits von anderen Hypervisoren kennen. Werfen wir jedoch einen kurzen Blick auf die erforderlichen Aufgaben:

Öffnen Sie die Veeam Backup & Replication-Konsole auf Ihrem Backup-Server oder Ihrer Management-Workstation. Um einen Backup-Job zu erstellen, navigieren Sie zum Tab Home und klicken Sie auf Backup Job, wählen Sie dann Virtual machine aus dem Dropdown-Menü.

Wenn der Assistent New Backup Job geöffnet wird, müssen Sie einen Namen und eine Beschreibung für den Backup-Job eingeben. Klicken Sie auf Next, um mit dem nächsten Schritt fortzufahren. Nun müssen Sie die VMs auswählen, die Sie sichern möchten. Klicken Sie im Schritt

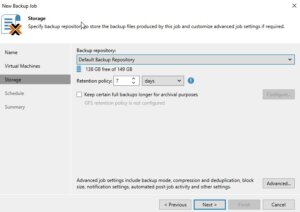

Der nächste Schritt besteht darin, anzugeben, wo Sie die Backup-Dateien speichern möchten. Wählen Sie im Schritt Storage das Backup-Repository aus und legen Sie die Aufbewahrungsrichtlinie fest, die bestimmt, wie lange Sie die Backup-Daten aufbewahren möchten. Nachdem Sie dies eingerichtet haben, klicken Sie auf Next.

Der nächste Schritt besteht darin, anzugeben, wo Sie die Backup-Dateien speichern möchten. Wählen Sie im Schritt Storage das Backup-Repository aus und legen Sie die Aufbewahrungsrichtlinie fest, die bestimmt, wie lange Sie die Backup-Daten aufbewahren möchten. Nachdem Sie dies eingerichtet haben, klicken Sie auf Next.

Wenn Sie mehrere Backup-Proxys konfiguriert haben, können Sie im nächsten Schritt festlegen, welchen Sie verwenden möchten. Wenn Sie sich nicht sicher sind oder es bevorzugen, können Sie Veeam Backup & Replication den besten Proxy für den Job automatisch auswählen lassen. Klicken Sie nach Ihrer Auswahl auf Next.

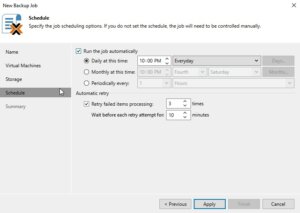

Nun ist es an der Zeit, den Zeitplan für die Ausführung des Backup-Jobs festzulegen. Im Schritt

Nun ist es an der Zeit, den Zeitplan für die Ausführung des Backup-Jobs festzulegen. Im Schritt

Überprüfen Sie alle Einstellungen auf der Übersichtsseite, um sicherzustellen, dass sie korrekt sind. Wenn alles in Ordnung ist, klicken Sie auf Finish, um den Backup-Job zu erstellen.

Wenn Sie den Backup-Job sofort ausführen möchten, um sicherzustellen, dass alles wie erwartet funktioniert, können Sie dies tun, indem Sie mit der rechten Maustaste auf den Job klicken und Start auswählen. Alternativ können Sie warten, bis die geplante Zeit den Job automatisch auslöst.

Wiederherstellen einer gesamten VM

Der Wiederherstellungs- und Replikationsprozess für eine vollständige VM-Wiederherstellung entspricht den Standardverfahren. Er umfasst jedoch nun die wichtige Funktion der Cross-Hypervisor-Wiederherstellung. Diese Funktionalität ermöglicht die Migration von VMs zwischen verschiedenen Hypervisor-Typen ohne Kompatibilitätsprobleme. Wenn beispielsweise Proxmox VE in einem Unternehmensumfeld eingeführt wird, können Administratoren VMs mühelos von einem bestehenden Hypervisor auf den Proxmox VE-Cluster migrieren. Sollten während der Testphase Probleme auftreten, unterstützt der Prozess auch die Rückmigration zum ursprünglichen Hypervisor. Werfen wir einen Blick auf die Details.

Öffnen Sie die Veeam Backup & Replication-Konsole auf Ihrem Backup-Server oder Ihrer Management-Workstation. Um einen Backup-Job zu erstellen, navigieren Sie zum Tab Home und klicken Sie auf Backup Job, wählen Sie dann Virtual machine aus dem Disk-Menü.

Wählen Sie die Option Entire VM restore, die den Assistenten zur Wiederherstellung einer vollständigen virtuellen Maschine startet. Im ersten Schritt des Assistenten werden Sie aufgefordert, ein Backup auszuwählen, aus dem Sie wiederherstellen möchten. Sie sehen eine Liste der verfügbaren Backups; wählen Sie dasjenige aus, das die VM enthält, die Sie wiederherstellen möchten, und fahren Sie mit dem nächsten Schritt fort, indem Sie auf Next klicken.

Nun müssen Sie den Wiederherstellungspunkt festlegen. Typischerweise ist dies das aktuellste Backup, aber Sie können bei Bedarf auch einen früheren Punkt wählen. Nachdem Sie den Wiederherstellungspunkt ausgewählt haben, fahren Sie mit dem nächsten Schritt fort.

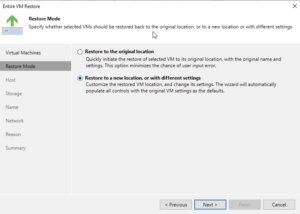

Der Assistent fordert Sie dann auf, das Ziel für die VM anzugeben. Dies ist der sehr praktische Punkt für die Cross-Hypervisor-Wiederherstellung, wo dies der ursprüngliche Speicherort oder ein neuer Speicherort sein kann, wenn Sie eine Migration durchführen oder die vorhandene VM nicht überschreiben möchten. Konfigurieren Sie die Netzwerkeinstellungen nach Bedarf, um sicherzustellen, dass die wiederhergestellte VM den entsprechenden Netzwerkzugriff hat.

Der Assistent fordert Sie dann auf, das Ziel für die VM anzugeben. Dies ist der sehr praktische Punkt für die Cross-Hypervisor-Wiederherstellung, wo dies der ursprüngliche Speicherort oder ein neuer Speicherort sein kann, wenn Sie eine Migration durchführen oder die vorhandene VM nicht überschreiben möchten. Konfigurieren Sie die Netzwerkeinstellungen nach Bedarf, um sicherzustellen, dass die wiederhergestellte VM den entsprechenden Netzwerkzugriff hat.

Im nächsten Schritt haben Sie Optionen bezüglich des Power-Zustands der VM nach der Wiederherstellung. Sie können wählen, ob die VM automatisch eingeschaltet oder ausgeschaltet bleiben soll, je nach Ihren Bedürfnissen.

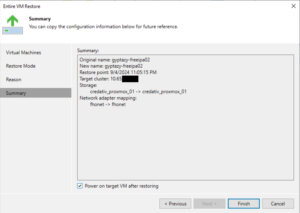

Bevor Sie den Wiederherstellungsprozess abschließen, überprüfen Sie alle Einstellungen, um sicherzustellen, dass sie Ihrem gewünschten Ergebnis entsprechen. Dies ist Ihre Chance, zurückzugehen und notwendige Anpassungen vorzunehmen. Sobald Sie mit der Konfiguration zufrieden sind, fahren Sie mit der Wiederherstellung der VM fort, indem Sie auf Finish klicken.

Bevor Sie den Wiederherstellungsprozess abschließen, überprüfen Sie alle Einstellungen, um sicherzustellen, dass sie Ihrem gewünschten Ergebnis entsprechen. Dies ist Ihre Chance, zurückzugehen und notwendige Anpassungen vorzunehmen. Sobald Sie mit der Konfiguration zufrieden sind, fahren Sie mit der Wiederherstellung der VM fort, indem Sie auf Finish klicken.

Der Wiederherstellungsprozess beginnt, und sein Fortschritt kann in der Veeam Backup & Replication-Konsole überwacht werden. Je nach Größe der VM und der Leistung Ihres Backup-Speichers und Netzwerks kann die Wiederherstellung einige Zeit in Anspruch nehmen.

Dateiwiederherstellung

Öffnen Sie die Veeam Backup & Replication-Konsole auf Ihrem Backup-Server oder Ihrer Management-Workstation. Um einen Backup-Job zu erstellen, navigieren Sie zum Tab Home und klicken Sie auf Backup Job, wählen Sie dann Virtual machine aus dem Disk-Menü.

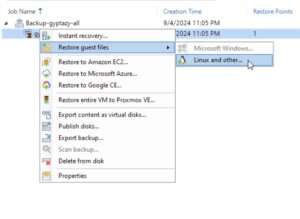

Wählen Sie Restore guest files. Der Assistent für die dateibasierte Wiederherstellung wird gestartet und führt Sie durch die notwendigen Schritte. Der erste Schritt besteht darin, das VM-Backup auszuwählen, aus dem Sie Dateien wiederherstellen möchten. Durchsuchen Sie die Liste der verfügbaren Backups, wählen Sie das passende aus und klicken Sie dann auf Next, um fortzufahren.

Wählen Sie Restore guest files. Der Assistent für die dateibasierte Wiederherstellung wird gestartet und führt Sie durch die notwendigen Schritte. Der erste Schritt besteht darin, das VM-Backup auszuwählen, aus dem Sie Dateien wiederherstellen möchten. Durchsuchen Sie die Liste der verfügbaren Backups, wählen Sie das passende aus und klicken Sie dann auf Next, um fortzufahren.

Wählen Sie den Wiederherstellungspunkt aus, den Sie für die dateibasierte Wiederherstellung verwenden möchten. Dies ist typischerweise das aktuellste Backup, aber Sie können bei Bedarf auch ein früheres auswählen. Nachdem Sie den Wiederherstellungspunkt ausgewählt haben, klicken Sie auf Next, um fortzufahren.

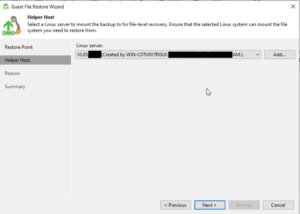

In diesem Schritt müssen Sie möglicherweise das Betriebssystem der VM auswählen, aus der Sie Dateien wiederherstellen. Dies ist besonders wichtig, wenn das Backup von einem anderen Betriebssystem stammt als dem auf dem Veeam Backup & Replication-Server, da dies den Typ der für die Wiederherstellung erforderlichen Helper Appliance bestimmt.

Veeam Backup & Replication fordert Sie auf, eine Helper Appliance bereitzustellen, wenn das Backup von einem Betriebssystem stammt, das vom Windows-basierten Veeam Backup & Replication-Server nicht nativ unterstützt wird. Befolgen Sie die Anweisungen auf dem Bildschirm, um die Helper Appliance bereitzustellen, die den dateibasierten Wiederherstellungsprozess erleichtern wird.

Veeam Backup & Replication fordert Sie auf, eine Helper Appliance bereitzustellen, wenn das Backup von einem Betriebssystem stammt, das vom Windows-basierten Veeam Backup & Replication-Server nicht nativ unterstützt wird. Befolgen Sie die Anweisungen auf dem Bildschirm, um die Helper Appliance bereitzustellen, die den dateibasierten Wiederherstellungsprozess erleichtern wird.

Sobald die Helper Appliance bereit ist, können Sie das Dateisystem des Backups durchsuchen. Navigieren Sie durch das Backup, um die Dateien oder Ordner zu finden, die Sie wiederherstellen möchten.

Nachdem Sie die Dateien oder Ordner zur Wiederherstellung ausgewählt haben, werden Sie aufgefordert, das Ziel auszuwählen, an das Sie die Daten wiederherstellen möchten. Sie können am ursprünglichen Speicherort wiederherstellen oder einen neuen Speicherort angeben, je nach Ihren Anforderungen.

Überprüfen Sie Ihre Auswahl, um zu bestätigen, dass die richtigen Dateien wiederhergestellt werden und am richtigen Ziel ankommen. Wenn alles in Ordnung ist, fahren Sie mit der Wiederherstellung fort, indem Sie auf Finish klicken.

Überprüfen Sie Ihre Auswahl, um zu bestätigen, dass die richtigen Dateien wiederhergestellt werden und am richtigen Ziel ankommen. Wenn alles in Ordnung ist, fahren Sie mit der Wiederherstellung fort, indem Sie auf Finish klicken.

Der dateibasierte Wiederherstellungsprozess beginnt, und Sie können den Fortschritt in der Veeam Backup & Replication-Konsole überwachen. Die Zeit, die für die Wiederherstellung benötigt wird, hängt von der Größe und Anzahl der wiederherzustellenden Dateien sowie von der Leistung Ihres Backup-Speichers und Netzwerks ab.

Fazit

Zusammenfassend lässt sich sagen, dass das neueste Update für Veeam eine sehr wichtige und willkommene Integration mit Proxmox VE einführt, die eine erhebliche Lücke für Unternehmen schließt, die diese Open-Source-Virtualisierungsplattform übernommen haben. Durch die Ermöglichung direkter Backups und Wiederherstellungen ganzer VMs über verschiedene Hypervisoren hinweg, ohne dass In-VM-Agenten erforderlich sind, bietet Veeam nun eine beispiellose Flexibilität und Einfachheit bei der Verwaltung gemischter Umgebungen. Diese Weiterentwicklung optimiert nicht nur Abläufe und verbessert Datenschutzstrategien, sondern ermöglicht es Unternehmen auch, neue Open-Source-Virtualisierungsplattformen wie Proxmox VE mit minimalem Risiko einfach zu migrieren und zu bewerten. Es ist großartig zu sehen, dass immer mehr Unternehmen Anstrengungen unternehmen, Open-Source-Lösungen zu unterstützen, was die anhaltende Bedeutung von Open-Source-basierten Produkten in Unternehmen unterstreicht.

Zusätzlich bleibt für diejenigen, die neu mit Proxmox beginnen, der Proxmox Backup Server eine praktikable Open-Source-Alternative, und Sie finden unseren Blogbeitrag zur Konfiguration des Proxmox Backup Servers direkt hier. Insgesamt stellt dieses Update einen bedeutenden Schritt zur Vereinheitlichung von Virtualisierungs- und Backup-Infrastrukturen dar, der sowohl Vielseitigkeit als auch einfache Integration bietet.

Wir stehen Ihnen jederzeit für weitere Beratungs-, Planungs- und Integrationsbedürfnisse zur Verfügung. Egal, ob Sie neue Virtualisierungsplattformen erkunden, Ihre aktuelle Infrastruktur optimieren oder fachkundige Beratung zu Ihren Backup-Strategien suchen, unser Team ist bestrebt, Ihren Erfolg auf jedem Schritt des Weges zu gewährleisten. Zögern Sie nicht, uns für personalisierten Support und maßgeschneiderte Lösungen zu kontaktieren, um Ihre einzigartigen Anforderungen in Virtualisierungs- oder Backup-Umgebungen zu erfüllen.

Wie und wann man Software-Defined Networks in Proxmox VE einsetzt

Was ist Software-Defined Networking?

Was ist Software-Defined Networking?

Wie man ein SDN konfiguriert

Nachdem wir nun die Grundlagen und Möglichkeiten von Software-Defined Networking (SDN) kennen, wird es interessant, ein solches Netzwerk innerhalb eines Proxmox-Clusters einzurichten.

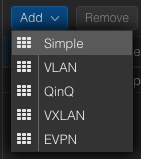

Proxmox bietet Unterstützung für Software-Defined Networking (SDN), sodass Benutzer verschiedene Arten von Netzwerkkonfigurationen integrieren können, um ihren spezifischen Netzwerkanforderungen gerecht zu werden. Mit Proxmox haben Sie die Flexibilität, aus verschiedenen SDN-Typen auszuwählen, darunter „Simple“, das wahrscheinlich auf unkomplizierte Netzwerkeinrichtungen ohne Bedarf an erweiterten Funktionen abzielt. Für Umgebungen, die eine Netzwerksegmentierung erfordern, ist VLAN-Unterstützung verfügbar, die die Möglichkeit bietet, den Datenverkehr innerhalb verschiedener virtueller LANs zu isolieren und zu verwalten. Komplexere Szenarien profitieren möglicherweise von der QinQ-Unterstützung, die mehrere VLAN-Tags auf einer einzigen Schnittstelle ermöglicht. Auch und sehr interessant für Rechenzentren: Proxmox bietet auch VxLAN-Unterstützung, die Layer-2-Netzwerke über eine Layer-3-Infrastruktur erweitert, was die Anzahl der möglichen VLANs erheblich erhöht, die sonst auf 4096 VLANs begrenzt wären. Zuletzt zu erwähnen ist die EVPN-Unterstützung, die ebenfalls Teil des SDN-Angebots von Proxmox ist, die erweiterte Layer-2- und Layer-3-Virtualisierung ermöglicht und eine skalierbare Steuerungsebene mit BGP (Border Gateway Protocol) für Multi-Tenancy-Umgebungen bietet.

In diesem Leitfaden führen wir Sie durch den Prozess der Einrichtung eines optimierten Software-Defined Network (SDN) innerhalb einer Proxmox-Clusterumgebung. Das Hauptziel ist die Einrichtung eines neuen Netzwerks, einschließlich seiner eigenen Netzwerkkonfiguration, die automatisch auf alle Knoten innerhalb des Clusters übertragen wird. Dieses neu erstellte Netzwerk wird durch seinen eigenen IP-Bereich erstellt, in dem virtuelle Maschinen (VMs) ihre IP-Adressen dynamisch über DHCP erhalten. Diese Einrichtung macht eine manuelle IP-Weiterleitung oder Network Address Translation (NAT) auf den Host-Maschinen überflüssig. Ein weiterer Vorteil dieser Konfiguration ist die Konsistenz, die sie bietet; das Gateway für die VMs bleibt immer konstant, unabhängig von dem spezifischen Host-Knoten, auf dem sie betrieben werden.

Konfiguration

Die Konfiguration von Software-Defined Networking (SDN) ist in den neuesten Proxmox VE-Versionen sehr einfach geworden, da der gesamte Prozess in der Proxmox-Weboberfläche durchgeführt werden kann. Daher verbinden wir uns einfach mit der Proxmox-Management-Weboberfläche, die typischerweise erreichbar ist unter:

- https://HOSTNAME:8006

Die SDN-Optionen sind im Datacenter-Kapitel im Unterkapitel SDN integriert. Alle weiteren Arbeiten werden nur innerhalb dieses Kapitels durchgeführt. Daher navigieren wir zu:

Die SDN-Optionen sind im Datacenter-Kapitel im Unterkapitel SDN integriert. Alle weiteren Arbeiten werden nur innerhalb dieses Kapitels durchgeführt. Daher navigieren wir zu:

–> Datacenter

—-> SDN

——–> Zonen

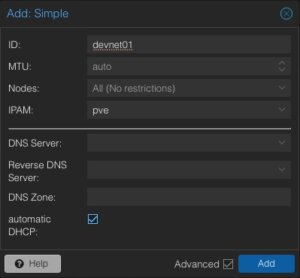

Das Menü auf der rechten Seite bietet die Möglichkeit, eine neue Zone hinzuzufügen, wobei die neue Zone vom Typ Simple ausgewählt wird. Es öffnet sich ein neues Fenster, in dem wir direkt die erweiterten Optionen unten aktivieren. Anschließend werden weitere erforderliche Details angegeben.

ID: devnet01

MTU: Auto

Nodes: All

IPAM: pve

Automatic DHCP: Activate

Die ID stellt die eindeutige Kennung dieser Zone dar. Es kann sinnvoll sein, ihr einen wiedererkennbaren Namen zu geben. Normalerweise müssen wir die MTU-Größe für diese Art von Standard-Setups nicht anpassen. Es kann jedoch immer einige Sonderfälle geben. In den Node-Abschnitten kann diese Zone bestimmten Nodes oder einfach allen zugewiesen werden. Es kann auch Szenarien geben, in denen Zonen nur auf bestimmte Nodes beschränkt sind. Entsprechend unseren erweiterten Optionen können weitere Details wie DNS-Server und auch die Forward- & Reverse-Zonen definiert werden. Für dieses grundlegende Setup wird dies nicht verwendet, aber die automatische DHCP-Option muss aktiviert werden.

Nun werden die nächsten Schritte im Kapitel VNets durchgeführt, wo die zuvor erstellte Zone mit einem virtuellen Netzwerk verknüpft wird. Im selben Schritt werden wir auch zusätzliche Netzwerkinformationen wie den Netzwerkbereich usw. angeben.

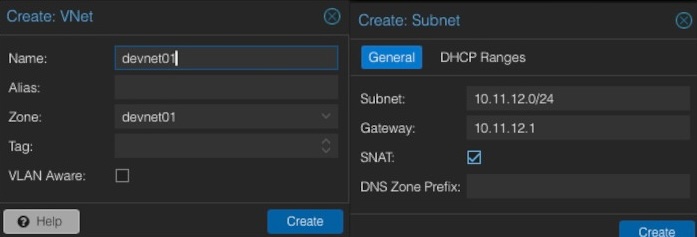

Beim Erstellen eines neuen VNet muss eine Kennung oder ein Name angegeben werden. Es ist oft sinnvoll, den Namen des virtuellen Netzwerks an den zuvor generierten Zonennamen anzupassen. In diesem Beispiel werden die gleichen Namen verwendet. Optional kann ein Alias definiert werden. Wichtig ist die Auswahl der gewünschten Zone, die verwendet werden soll (z. B. devnet01). Nach dem Erstellen des neuen VNet haben wir die Möglichkeit, im selben Fenster ein neues Subnetz zu erstellen, indem wir auf die Schaltfläche Create Subnet klicken.

Innerhalb dieses Dialogs werden einige grundlegende Netzwerkinformationen eingegeben. Im Allgemeinen müssen wir das gewünschte Subnetz in CIDR-Notation angeben (z. B. 10.11.12.0/24). Die Definition der IP-Adresse für das Gateway ist ebenfalls möglich. In diesem Beispiel wird das Gateway auf der IP-Adresse 10.11.12.1 platziert. Wichtig ist die Aktivierung der Option SNAT. SNAT (Source Network Address Translation) ist eine Technik, um die Quell-IP-Adresse des ausgehenden Netzwerkverkehrs so zu ändern, dass es so aussieht, als ob er von einer anderen IP-Adresse stammt, die normalerweise die IP-Adresse des Routers oder der Firewall ist. Diese Methode wird häufig verwendet, um mehreren Geräten in einem privaten Netzwerk den Zugriff auf externe Netzwerke zu ermöglichen.

Nach dem Erstellen und Verknüpfen der Zone, des VNet und des Subnetzes kann die Konfiguration einfach auf der Weboberfläche angewendet werden, indem auf die Schaltfläche „Apply“ geklickt wird. Die Konfiguration wird nun mit den gewünschten Nodes synchronisiert (in unserem Beispiel alle).

Nutzung

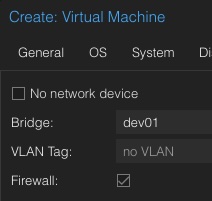

Nach dem Anwenden der Konfiguration auf die Nodes innerhalb des Clusters müssen virtuelle Maschinen noch diesem Netzwerk zugewiesen werden. Glücklicherweise kann dies einfach über die reguläre Proxmox-Weboberfläche erfolgen, die nun auch das neu erstellte Netzwerk devnet01 im Networking-Kapitel der VM bereitstellt. Aber auch bereits vorhandene virtuelle Maschinen können diesem Netzwerk zugewiesen werden.

Nach dem Anwenden der Konfiguration auf die Nodes innerhalb des Clusters müssen virtuelle Maschinen noch diesem Netzwerk zugewiesen werden. Glücklicherweise kann dies einfach über die reguläre Proxmox-Weboberfläche erfolgen, die nun auch das neu erstellte Netzwerk devnet01 im Networking-Kapitel der VM bereitstellt. Aber auch bereits vorhandene virtuelle Maschinen können diesem Netzwerk zugewiesen werden.

Wenn es um DevOps und Automatisierung geht, ist dies auch in der API verfügbar, wo virtuelle Maschinen dem neuen Netzwerk zugewiesen werden können. Eine solche Aufgabe könnte im folgenden Beispiel in Ansible wie folgt aussehen:

- name: Create Container in Custom Network

community.general.proxmox:

vmid: 100

node: de01-dus01-node03

api_user: root@pam

api_password: {{ api_password }}

api_host: de01-dus01-node01

password: {{ container_password }}

hostname: {{ container_fqdn }}

ostemplate: 'local:vztmpl/debian-12-x86_64.tar.gz'

netif: '{"net0":"name=eth0,ip=dhcp,ip6=dhcp,bridge=devnet01"}'

Virtuelle Maschinen, die diesem Netzwerk zugewiesen sind, erhalten sofort IP-Adressen innerhalb unseres zuvor definierten Netzwerks 10.11.12.0/24 und können ohne weitere Bedürfnisse auf das Internet zugreifen. VMs können auch über Nodes im Cluster verschoben werden, ohne dass das Gateway angepasst werden muss, selbst wenn ein Node heruntergefahren oder für Wartungsarbeiten neu gestartet wird.

Fazit

Zusammenfassend lässt sich sagen, dass die Integration von Software-Defined Networking (SDN) in Proxmox VE einen großen Vorteil aus technischer Sicht, aber auch aus Benutzersicht darstellt, da diese Funktion auch über die Proxmox-Weboberfläche nutzbar ist. Diese einfache Konfiguration ermöglicht es auch Personen mit begrenzter Netzwerkerfahrung, noch komplexere Netzwerkeinrichtungen einzurichten und zu verwalten.

Proxmox erleichtert es auch mit einfachen SDNs, grundlegende Netzwerke zu erstellen, die virtuelle Maschinen mit dem Internet verbinden. Sie müssen sich nicht mit komplizierten Einstellungen oder Gateways auf den Hauptknoten befassen. Dies beschleunigt die Inbetriebnahme virtueller Setups und verringert die Wahrscheinlichkeit von Fehlern, die zu Sicherheitsproblemen führen könnten.

Für Leute, die gerade erst anfangen, hat Proxmox eine benutzerfreundliche Website, die es einfach macht, Netzwerke einzurichten und zu steuern. Das ist wirklich hilfreich, weil es bedeutet, dass sie nicht viel kompliziertes Zeug lernen müssen, um loszulegen. Stattdessen können sie mehr Zeit damit verbringen, mit ihren virtuellen Computern zu arbeiten, und sich nicht zu viele Sorgen darüber machen, wie sie alles verbinden.

Leute, die mehr über Technologie wissen, werden es mögen, wie Proxmox ihnen erlaubt, komplexe Netzwerke einzurichten. Das ist gut für große Setups, weil es das Netzwerk besser laufen lassen, mehr Verkehr bewältigen und verschiedene Teile des Netzwerks voneinander trennen kann.

Genau wie andere nützliche Integrationen (z. B. Ceph) bietet auch die SDN-Integration große Vorteile für seine Benutzerbasis und zeigt die laufende Integration nützlicher Tools in Proxmox.

NetApp-Speicher und NVMe-oF für bahnbrechende Leistung in Proxmox-Virtualisierungsumgebungen

Was ist NVMe-oF

NVMe over Fabrics (NVMe-oF) ist ein hochmodernes Protokoll, das entwickelt wurde, um die beeindruckende Leistung und die geringe Latenz von NVMe-Speichergeräten über Netzwerk-Fabrics zu übertragen. Diese Innovation ist besonders transformativ für Rechenzentren, da sie die Trennung von Speicher- und Rechenressourcen ermöglicht, wodurch Administratoren die Möglichkeit erhalten, diese Ressourcen flexibler und mit größerer Skalierbarkeit bereitzustellen, was es perfekt für Virtualisierungs-Workloads macht.

NVMe-oF ist vielseitig in seiner Unterstützung für mehrere Transportschichten, wo es über Fibre Channel (FC), Ethernet mit dem TCP/IP-Protokoll mit RDMA-Funktionen über RoCE oder iWARP und sogar InfiniBand betrieben werden kann, wobei jede einzigartige Leistungsmerkmale bietet, die auf unterschiedliche Bereitstellungsanforderungen zugeschnitten sind.

NVMe-oF über TCP

Wenn NVMe-oF über Ethernet mit TCP bereitgestellt wird, bringt es die Vorteile von NVMe-Speicher in die größtmögliche Bandbreite von Umgebungen, ohne dass eine spezialisierte Netzwerkinfrastruktur wie Fibre Channel oder InfiniBand erforderlich ist. Dies ermöglicht den Zugriff auf Hochleistungsspeicher durch die Nutzung des gängigen und vertrauten TCP-Stacks, wodurch Komplexität und Kosten erheblich reduziert werden. Die Einführung von NVMe-oF mit TCP wird durch die weite Verbreitung von Ethernet und Fachwissen weiter erleichtert, was es zu einer überzeugenden Wahl für Unternehmen macht, die ihre Speichernetzwerke ohne eine komplette Überarbeitung aufrüsten möchten.

Die Effizienz des Protokolls bleibt auch über TCP gut erhalten, wodurch NVMe-Befehle mit minimalem Overhead übergeben werden können, was die Latenz gering hält und für latenzempfindliche Anwendungen wie virtualisierte Datenserver entscheidend ist.

NetApp-Speicher konfigurieren

Allgemein

Der Leitfaden setzt voraus, dass Benutzer die grundlegende Speichereinrichtung bereits vorgenommen haben, einschließlich der Konfiguration von Storage Virtual Machines (SVMs). Er hebt hervor, dass die Verwaltung dieser Systeme dank der intuitiven Weboberfläche, die von NetApp-Speichersystemen bereitgestellt wird, relativ unkompliziert ist. Benutzer können eine benutzerfreundliche Erfahrung bei der Verwaltung ihrer Speicherlösungen erwarten, da die Weboberfläche darauf ausgelegt ist, komplexe Aufgaben zu vereinfachen. Dies umfasst auch die gesamte Einrichtung für NVMe-oF-Speicher, was erfordert, NVMe generell auf der SVM zu aktivieren, den NVMe-Namespace und das NVMe-Subsystem einzurichten.

Hinweis: Alle Änderungen können selbstverständlich auch automatisiert durch Orchestrierung der OnTap API vorgenommen werden.

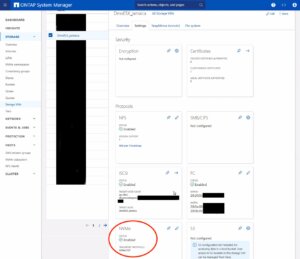

NVMe auf SVM aktivieren

Um NVMe auf SVM-Ebene in einem NetApp-Speichersystem zu aktivieren, kann dies typischerweise durch Befolgen dieser zusammengefassten Schritte erfolgen, die über die Weboberfläche des Systems zugänglich sind. Navigieren Sie einfach zum Menü Storage, dann zu Storage VMs und wählen Sie schließlich den spezifischen SVM-Namen aus, den Sie konfigurieren möchten:

Um NVMe auf SVM-Ebene in einem NetApp-Speichersystem zu aktivieren, kann dies typischerweise durch Befolgen dieser zusammengefassten Schritte erfolgen, die über die Weboberfläche des Systems zugänglich sind. Navigieren Sie einfach zum Menü Storage, dann zu Storage VMs und wählen Sie schließlich den spezifischen SVM-Namen aus, den Sie konfigurieren möchten:

- NVMe-Protokoll konfigurieren: Suchen Sie innerhalb der SVM-Einstellungen nach einem Abschnitt oder Tab, der sich auf Protokolle bezieht. Suchen Sie die NVMe-Option und aktivieren Sie sie. Dies kann das Aktivieren eines Kontrollkästchens oder das Umschalten eines Schalters in die Position ‚Ein‘ beinhalten.

- Änderungen speichern und anwenden: Nachdem Sie NVMe aktiviert haben, stellen Sie sicher, dass Sie die Änderungen speichern. Es können zusätzliche Aufforderungen oder Schritte zur Bestätigung der Änderungen erforderlich sein, abhängig vom spezifischen NetApp-System und seiner Version.

Denken Sie daran, alle Voraussetzungen oder zusätzlichen Konfigurationseinstellungen zu prüfen, die für den NVMe-Betrieb erforderlich sein könnten, wie Netzwerkeinstellungen, Lizenzierung oder Kompatibilitätsprüfungen der Hardware. Die genauen Schritte können je nach ONTAP-Version oder dem spezifischen NetApp-Modell, das Sie verwenden, leicht variieren. Beziehen Sie sich immer auf die neueste offizielle NetApp-Dokumentation oder Support-Ressourcen für die genaueste Anleitung.

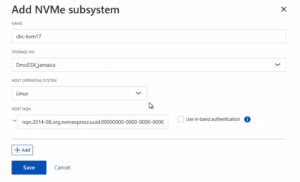

Das NVMe-Subsystem erstellen

Anschließend kann ein neues NVMe-Subsystem auf dem NetApp-Speichersystem erstellt werden. Dies kann durch Auswahl des Abschnitts Hosts und Auswahl von NVMe Subsystem erfolgen, um den Prozess des Hinzufügens eines neuen Subsystems zu starten. Ein neuer Assistent öffnet sich, der zusätzliche Informationen zum neu zu erstellenden Subsystem erfordert:

Name: <Ein Bezeichner des NVMe-Subsystems>

Name: <Ein Bezeichner des NVMe-Subsystems>

Storage VM: <Die zuvor angepasste SVM>

Host-Betriebssystem: Linux (wichtig für die Blockgröße)

Host NQN: <NQN des Proxmox VE-Knotens>

Es ist unerlässlich sicherzustellen, dass alle Informationen, insbesondere der Host-NQN, korrekt eingegeben werden, um Konnektivitätsprobleme zu vermeiden. Konsultieren Sie zusätzlich die offizielle NetApp-Dokumentation für versionsspezifische Anweisungen oder zusätzliche Konfigurationsschritte, die erforderlich sein könnten.

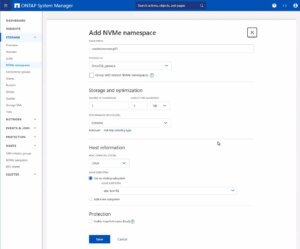

Den NVMe-Namespace erstellen

Als letzten Schritt muss der NVMe-Namespace erstellt werden. Um einen NVMe-Namespace auf einem NetApp-Speichersystem hinzuzufügen, melden Sie sich zunächst bei der Weboberfläche an und navigieren Sie zum Abschnitt Storage, gefolgt von der Auswahl von NVMe Namespaces. In diesem Bereich initiieren Sie den Prozess der Erstellung eines neuen Namespace. Sie werden aufgefordert, spezifische Details für den Namespace anzugeben, wie seinen Namen, seine Größe und die zugehörige SVM, die ihn verwalten wird.

Als letzten Schritt muss der NVMe-Namespace erstellt werden. Um einen NVMe-Namespace auf einem NetApp-Speichersystem hinzuzufügen, melden Sie sich zunächst bei der Weboberfläche an und navigieren Sie zum Abschnitt Storage, gefolgt von der Auswahl von NVMe Namespaces. In diesem Bereich initiieren Sie den Prozess der Erstellung eines neuen Namespace. Sie werden aufgefordert, spezifische Details für den Namespace anzugeben, wie seinen Namen, seine Größe und die zugehörige SVM, die ihn verwalten wird.

Hinweis: Beachten Sie auch einen wichtigen Hinweis zum Performance Service Level, der möglicherweise auf ein benutzerdefiniertes Profil umgestellt werden sollte, um Einschränkungen zu vermeiden.

Sobald Sie alle erforderlichen Informationen eingegeben haben, werden Sie typischerweise fortfahren, die Leistungsmerkmale auszuwählen, wie das Service Level oder die Tiering-Richtlinie, abhängig von Ihren Leistungsanforderungen und den Fähigkeiten Ihres NetApp-Systems.

Nachdem Sie diese Einstellungen konfiguriert haben, müssen Sie Ihre Auswahl überprüfen und die neue Namespace-Konfiguration speichern, um sie zur Verwendung verfügbar zu machen. Es ist wichtig sicherzustellen, dass der Namespace ordnungsgemäß konfiguriert ist, um den Anforderungen Ihrer Umgebung für optimale Leistung und Kompatibilität zu entsprechen. Überprüfen Sie immer auf zusätzliche Schritte oder Voraussetzungen, indem Sie die NetApp-Dokumentation konsultieren, die für Ihre ONTAP-Version oder Ihr Speichermodell relevant ist.

Die Konfiguration auf der Speicherseite ist nun abgeschlossen. Die nächsten Schritte werden auf dem/den Proxmox VE-Knoten durchgeführt.

Proxmox-Knoten konfigurieren

Allgemein

Nach der Konfiguration der NetApp-Speicherappliance müssen alle Proxmox VE-Knoten innerhalb des Clusters für die Nutzung und den Zugriff auf den NVMe-oF-Speicher konfiguriert werden. Leider unterstützt Proxmox VE diese Art von Speicher nicht von Haus aus. Daher kann dies nicht einfach über die Proxmox-Weboberfläche konfiguriert werden. Glücklicherweise basiert Proxmox VE auf Debian Linux, von wo aus alle benötigten Abhängigkeiten und Konfigurationen bezogen werden können, aber es erfordert, dass wir alles über die Kommandozeile (CLI) erledigen. Abhängig von der Anzahl der Knoten innerhalb des Clusters können weitere Konfigurationsmanagement-Tools wie Ansible den anfänglichen Einrichtungsprozess beschleunigen und für neue potenzielle Knoten in der Zukunft wiederholbar machen. Wir können Sie auch bei der Einrichtung maßgeschneiderter Konfigurationsmanagement-Umgebungen unterstützen, die Ihren Anforderungen entsprechen.

Im Allgemeinen besteht dieser Prozess aus:

- Erforderliche Pakete installieren.

- Die Kernel-Module aktivieren.

- Erkennung des Speichers.

- Verbindung mit dem Speicher herstellen.

- Eine LVM-Volume-Gruppe erstellen.

- Den Speicher in der Proxmox-Weboberfläche zuweisen.

Die nächsten Schritte in diesem Blogbeitrag werden den Prozess detailliert behandeln und Sie durch die erforderlichen Schritte auf den Proxmox VE-Knoten führen, die auf der Kommandozeile ausgeführt werden müssen.

Erforderliche Pakete installieren

Die Nutzung und der Zugriff auf NVMe-oF erfordert, dass die zugehörigen User-Land-Tools (nvme-cli) auf dem Proxmox VE-Knoten vorhanden sind. Debian Linux stellt diese Tools bereits im Debian-Repository bereit. Daher ist der gesamte Installationsprozess sehr einfach. Das Paket kann einfach mit dem folgenden Befehl installiert werden:

apt-get install nvme-cli

Dieses Paket stellt auch bereits das erforderliche Kernel-Modul bereit, das einfach durch Ausführen von geladen werden kann:

modprobe nvme_tcp

Anschließend sollte das Modul hinzugefügt werden, um beim Booten geladen zu werden:

echo "nvme_tcp" > /etc/modules-load.d/20-nvme_tcp.conf

Nach diesen Schritten kann eine Verbindung mit dem Speicher initialisiert werden.

Verbindung mit dem Speicher herstellen

Die Interaktion mit dem NetApp-Speicher und seiner NVMe-oF-Funktionalität ist ein mehrstufiger Prozess und erfordert den Austausch der NVMe Qualified Name (NQN)-Adresse jedes Proxmox VE-Knotens, der auf den NVMe-Speicher zugreift. Die NQN-Adresse eines Proxmox VE-Knotens kann durch Ausführen des Befehls abgerufen werden:

cat /etc/nvme/hostnqn

![]()

Fügen Sie die Host-NQN-Adresse zu Ihrem NetApp-Export hinzu, um den Knoten den Zugriff darauf zu ermöglichen. Eine Beispielausgabe ist im Screenshot angegeben.

Erkennung & Verbindung

Im nächsten Schritt werden die NVMe-Geräte erkannt und mit dem Proxmox VE-Knoten verbunden. Der Erkennungs- und Verbindungsprozess erfolgt einfach durch Ausführen der folgenden Befehle:

nvme discover -t tcp -a 192.168.164.100 -s 4420

nvme connect -t tcp -n na01-nqn01 -a 192.168.164.100 -s 4420

Um diese Konfiguration systemneustartfest zu machen, werden die Befehle auch zur nvme-Discovery-Datei hinzugefügt. Die nvmf-autoconnect systemd-Unit-Datei stellt sicher, dass dies geladen wird. Daher muss diese systemd-Unit-Datei ebenfalls aktiviert werden.

echo "discover -t tcp -a 192.168.164.100 -s 4420" >> etc/nvme/discovery.conf

systemctl enable nvmf-autoconnect.service

Volume-Gruppe

Die letzten Schritte werden teilweise auf der Kommandozeile und teilweise über die Proxmox-Weboberfläche durchgeführt, um den neuen Speicher zum Cluster hinzuzufügen.

Wichtig:

Diese Schritte dürfen nur auf einem einzelnen Proxmox VE Host-Knoten und nicht auf allen durchgeführt werden. Die Integration erfolgt auf Clusterebene und betrifft alle Proxmox VE-Knoten, sobald dies geschehen ist.

Der letzte Befehl auf der Kommandozeile führt zur Erstellung einer neuen LVM Volume Group (VG) auf dem neuen NVMe-Gerät, was einfach durch Ausführen des Befehls geschehen kann:

vgcreate shared_nvme01 /dev/nvme0n1

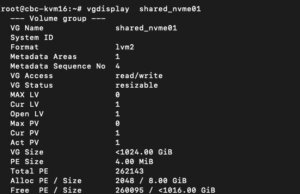

Die neu erstellte LVM Volume Group (VG) kann durch Ausführen des Befehls validiert werden:

vgdisplay shared_nvme01

Eine Ausgabe wie im angegebenen Screenshot sollte zurückgegeben werden, einschließlich aller weiteren Details dieser VG. Nach der Validierung der Informationen sind alle Aufgaben auf der Kommandozeile abgeschlossen.

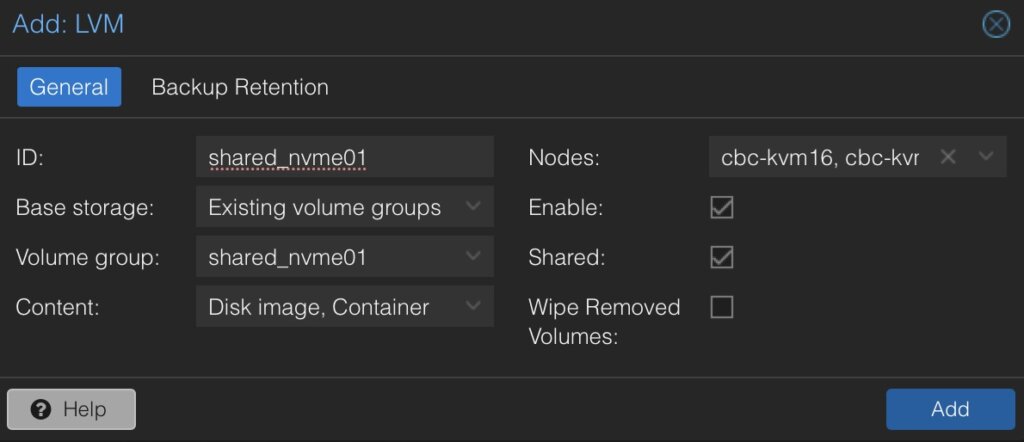

Um diese LVM Volume Group schließlich auf allen Proxmox VE-Knoten innerhalb des Clusters zu verwenden, muss diese Volume Group auf Clusterebene hinzugefügt und integriert werden. Dazu müssen wir uns im Web-Frontend des Clusters anmelden und dies unter hinzufügen:

- Datacenter

- Storage

- Hinzufügen

- LVM

Im neuen Fenster müssen weitere Details für den neuen LVM-Speicher definiert werden:

- ID: shared_nvme01 (dies kann beliebiger Text sein und ist lediglich ein Bezeichner)

- Basisspeicher: Bestehende Volume-Gruppen

- Volume-Gruppe: shared_nvme01

- Inhalt: Disk-Image, Container (kann variieren)

- Knoten: <Wählen Sie alle Knoten aus, die es verwenden sollen>

- Aktiviert: Ja

- Freigegeben: Ja

- Entfernte Volumes löschen: Nein

Durch Klicken auf Hinzufügen wird dies als neues Volume an die ausgewählten Knoten angehängt und kann direkt verwendet werden.

Fazit

Die Nutzung von NVMe over Fabrics (NVMe-oF) über TCP in Verbindung mit Proxmox VE in einer Virtualisierungsumgebung stellt eine überzeugende Lösung für Organisationen dar, die kostengünstige und dennoch hochleistungsfähige Speicherarchitekturen suchen. Dieser Ansatz nutzt die weite Verbreitung und Kompatibilität von Ethernet-basierten Netzwerken, wodurch die Notwendigkeit spezialisierter Hardware wie Fibre Channel oder InfiniBand vermieden wird, die für viele Unternehmen kostenintensiv sein kann.

Durch die Integration von NVMe-oF mit Proxmox, einer beliebten Open-Source-Virtualisierungsplattform, können Benutzer von deutlich verbesserten Datenübertragungsgeschwindigkeiten und geringerer Latenz im Vergleich zu traditionellen Speicherlösungen profitieren. NVMe-oF kann nicht nur mit Proxmox VE, sondern auch auf anderen Betriebssystemen wie FreeBSD und Hypervisoren wie bhyve verwendet werden. Dies bietet einen großen Vorteil für latenzempfindliche Workloads, wie virtualisierte Datenbankserver, wo schneller Datenzugriff für die Leistung entscheidend ist. Das NVMe-Protokoll ist darauf ausgelegt, das volle Potenzial von Solid-State-Speichertechnologien auszuschöpfen. Bei Verwendung über ein Netzwerk-Fabric mittels TCP kann es eine nahezu lokale NVMe-Leistung liefern, indem es sehr kostengünstig ist.

Gerne stehen wir Ihnen zur Verfügung, um weitere Einblicke in NetApp-Speichersysteme zu geben, die sowohl Hardware- als auch Softwareaspekte abdecken. Unsere Expertise erstreckt sich auch auf Open-Source-Produkte, insbesondere bei der Einrichtung von Virtualisierungsumgebungen mit Technologien wie Proxmox und OpenShift oder deren Wartung mit Konfigurationsmanagement. Wir laden Sie ein, sich bei Bedarf an uns zu wenden.

Es könnte Sie auch interessieren zu erfahren, wie Sie VMs von VMware ESXi zu Proxmox VE migrieren oder wie Sie den Proxmox Backup Server in Ihre Infrastruktur integrieren können.

Migration von VMs von VMware ESXi zu Proxmox

Als Reaktion auf Broadcoms jüngste Änderungen im Abonnementmodell von VMware überdenken immer mehr Unternehmen ihre Virtualisierungsstrategien. Angesichts erhöhter Bedenken hinsichtlich Lizenzkosten und Feature-Zugänglichkeit wenden sich Unternehmen open source Lösungen zu, um mehr Flexibilität und Kosteneffizienz zu erzielen.

Vorteile von Open-Source-Lösungen

In der dynamischen Landschaft des modernen Geschäftslebens stellt die Entscheidung für open source Lösungen für die Virtualisierung einen strategischen Vorteil für Unternehmen dar. Mit Plattformen wie KVM, Xen und sogar LXC-Containern können Unternehmen von der Abwesenheit von Lizenzgebühren profitieren, was erhebliche Kosteneinsparungen ermöglicht und Ressourcen in Innovation und Wachstum umleitet. Diese finanzielle Flexibilität ermöglicht es Unternehmen, strategische Investitionen in ihre IT-Infrastruktur zu tätigen, ohne die Belastung durch proprietäre Lizenzkosten. Darüber hinaus fördert die Open-Source-Virtualisierung die Zusammenarbeit und Transparenz, sodass Unternehmen ihre Umgebungen an ihre individuellen Bedürfnisse anpassen und nahtlos in bestehende Systeme integrieren können. Durch die Community-gesteuerte Entwicklung und robuste Support-Netzwerke erhalten Unternehmen Zugang zu einem reichen Wissens- und Ressourcenpool, der die Zuverlässigkeit, Sicherheit und Skalierbarkeit ihrer virtualisierten Infrastruktur gewährleistet. Die Nutzung der Open-Source-Virtualisierung bietet nicht nur greifbare finanzielle Vorteile, sondern stattet Unternehmen auch mit der Agilität und Anpassungsfähigkeit aus, die sie benötigen, um in einer sich ständig weiterentwickelnden digitalen Landschaft erfolgreich zu sein.

Migrieren einer VM

Voraussetzungen

Um einen reibungslosen Migrationsprozess von VMware ESXi zu Proxmox zu gewährleisten, müssen mehrere wichtige Schritte unternommen werden. Zunächst muss der SSH-Zugriff sowohl auf dem VMware ESXi-Host als auch auf dem Proxmox-Host aktiviert werden, um die Remote-Verwaltung und -Administration zu ermöglichen. Zusätzlich ist es entscheidend, Zugriff auf beide Systeme zu haben, um den Migrationsprozess zu erleichtern. Des Weiteren ist die Herstellung einer SSH-Verbindung zwischen VMware ESXi und Proxmox für eine nahtlose Kommunikation zwischen den beiden Plattformen unerlässlich. Dies gewährleistet eine effiziente Datenübertragung und -verwaltung während der Migration. Darüber hinaus ist es zwingend erforderlich, das Proxmox VE-System oder den Cluster ähnlich dem ESXi-Setup zu konfigurieren, insbesondere hinsichtlich der Netzwerkkonfigurationen. Dies beinhaltet die Sicherstellung der Kompatibilität mit VLANs oder VXLANs für komplexere Setups. Zusätzlich sollten beide Systeme entweder auf lokalem Speicher laufen oder Zugriff auf gemeinsamen Speicher, wie NFS, haben, um die Übertragung von virtuellen Maschinendaten zu erleichtern. Schließlich ist es vor Beginn der Migration unerlässlich zu überprüfen, ob das Proxmox-System über ausreichend verfügbaren Speicherplatz verfügt, um die importierte virtuelle Maschine aufzunehmen und so einen erfolgreichen Übergang ohne Speicherengpässe zu gewährleisten.

SSH auf ESXi aktivieren

Der SSH-Server muss aktiviert sein, um den Inhalt vom ESXi-System an den neuen Speicherort auf dem Proxmox-Server zu kopieren. Die virtuelle Maschine wird später auf den Proxmox-Server kopiert. Daher ist es notwendig, dass das Proxmox-System eine SSH-Verbindung über tcp/22 zum ESXi-System herstellen kann:

- Melden Sie sich beim VMware ESXi-Host an.

- Navigieren Sie zu Konfiguration > Sicherheitsprofil.

- Aktivieren Sie SSH unter Dienste.

Quellinformationen über VM auf ESXi finden

Eine der herausfordernden Aufgaben ist das Auffinden des Speicherorts der virtuellen Maschine, die die virtuelle Festplatte enthält. Der Pfad kann in der Web-UI des ESXi-Systems gefunden werden:

- Suchen Sie den ESXi-Knoten, auf dem die virtuelle Maschine ausgeführt wird, die migriert werden soll

- Identifizieren Sie die zu migrierende virtuelle Maschine (z. B. pgsql07.gyptazy.ch).

- Ermitteln Sie den Speicherort der virtuellen Festplatte (VMDK), die der VM zugeordnet ist, über das Konfigurationsfeld.

- Der VM-Speicherortpfad sollte angezeigt werden (z. B. /vmfs/volumes/137b4261-68e88bae-0000-000000000000/pgsql07.gyptazy.ch).

- VM stoppen und herunterfahren.

Eine neue leere VM auf Proxmox erstellen

- Erstellen Sie eine neue leere VM in Proxmox.

- Weisen Sie die gleichen Ressourcen wie im ESXi-Setup zu.

- Stellen Sie den Netzwerktyp auf VMware vmxnet3 ein.

- Stellen Sie sicher, dass die benötigten Netzwerkressourcen (z. B. VLAN, VXLAN) ordnungsgemäß konfiguriert sind.

- Stellen Sie den SCSCI-Controller für die Festplatte auf VMware PVSCSI ein.

- Erstellen Sie keine neue Festplatte (diese wird später von der ESXi-Quelle importiert).

- Jede VM erhält eine von Proxmox zugewiesene ID (notieren Sie diese, sie wird später benötigt).

VM von ESXi zu Proxmox kopieren

Der Inhalt der virtuellen Maschine (VM) wird vom ESXi- auf das Proxmox-System mithilfe des open source Tools rsync zur effizienten Synchronisierung und Kopie übertragen. Daher müssen die folgenden Befehle vom Proxmox-System aus ausgeführt werden, wo wir ein temporäres Verzeichnis zur Speicherung des VM-Inhalts erstellen:

mkdir /tmp/migration_pgsql07.gyptazy.ch cd /tmp/migration_pgsql07.gyptazy.ch rsync -avP root@esx02-test.gyptazy.ch:/vmfs/volumes/137b4261-68e88bae-0000-000000000000/pgsq07.gyptazy.ch/* .

Abhängig von der Dateigröße der virtuellen Maschine und der Netzwerkkonnektivität kann dieser Vorgang einige Zeit dauern.

VM in Proxmox importieren

Anschließend wird die Festplatte mit dem qm-Dienstprogramm importiert, wobei die VM-ID (die während des VM-Erstellungsprozesses erstellt wurde) definiert wird, sowie der Festplattenname (der kopiert wurde) und der Zieldatenspeicher auf dem Proxmox-System angegeben werden, wo die VM-Festplatte gespeichert werden soll:

Anschließend wird die Festplatte mit dem qm-Dienstprogramm importiert, wobei die VM-ID (die während des VM-Erstellungsprozesses erstellt wurde) definiert wird, sowie der Festplattenname (der kopiert wurde) und der Zieldatenspeicher auf dem Proxmox-System angegeben werden, wo die VM-Festplatte gespeichert werden soll:

qm disk import 119 pgsql07.gyptazy.ch.vmdk local-lvm

Abhängig vom Erstellungsformat der VM oder dem Exportformat kann es mehrere Festplattendateien geben, die auch mit _flat ergänzt werden können. Dieses Verfahren muss für alle verfügbaren Festplatten wiederholt werden.

VM starten

Im letzten Schritt sollten alle Einstellungen, Ressourcen, Definitionen und Anpassungen des Systems gründlich überprüft werden. Nach der Validierung kann die VM gestartet werden, um sicherzustellen, dass alle Komponenten für den Betrieb in der Proxmox-Umgebung korrekt konfiguriert sind.

Fazit

Dieser Artikel behandelt nur eine von vielen möglichen Methoden für Migrationen in einfachen, eigenständigen Setups. In komplexeren Umgebungen mit mehreren Host-Knoten und verschiedenen Speichersystemen wie Fibre Channel oder Netzwerkspeicher gibt es erhebliche Unterschiede und zusätzliche Überlegungen. Darüber hinaus kann es spezifische Anforderungen in Bezug auf Verfügbarkeit und Service Level Agreements (SLAs) geben, die zu berücksichtigen sind. Dies kann für jede Umgebung sehr spezifisch sein. Sie können sich jederzeit gerne an uns wenden, um eine persönliche Beratung zu Ihren spezifischen Migrationsanforderungen zu erhalten. Gerne bieten wir Ihnen auch unsere Unterstützung in verwandten Bereichen in open source wie Virtualisierung (z. B. OpenStack, VirtualBox) und Themen im Zusammenhang mit Cloud-Migrationen an.

Nachtrag

Am 27. März hat Proxmox seinen neuen Import-Assistenten (pve-esxi-import-tools) veröffentlicht, der Migrationen von VMware ESXi-Instanzen in eine Proxmox-Umgebung erheblich vereinfacht. In einem kommenden Blogbeitrag werden wir weitere Informationen zu den neuen Tools und Anwendungsfällen bereitstellen, in denen diese nützlicher sein könnten, aber auch die Randfälle behandeln, in denen der neue Import-Assistent nicht verwendet werden kann.

Was ist Software-Defined Networking?

Was ist Software-Defined Networking?