Virtualisierung & „Rheinischer Kaviar“: Einladung zum Business-Frühstück bei credativ am 19.03.2026

Keine Lust mehr auf Lizenz-Dschungel und komplexe „Black Boxes“? Oder haben Sie schon von Proxmox gehört, hatten aber bisher keine Zeit, sich das Ganze mal in Ruhe und ohne Vertriebsdruck anzuschauen?

Wir laden Sie herzlich zu einem entspannten Business-Frühstück am 19.03.2026 an unserem Standort in Mönchengladbach ein. Egal, ob Sie Virtualisierungs-Neuling sind oder als erfahrener IT-Admin nach einer echten Open-Source-Alternative suchen – bei uns gibt es keine trockenen Folien-Schlachten, sondern echte Live-Demos, ehrlichen Austausch und verdammt guten Kaffee.

Was Sie erwartet

- 09:30 Uhr | Ankommen & Koffein-Check Erstmal einen Kaffee greifen, entspannt ankommen und die anderen Teilnehmer kennenlernen.

- 10:00 Uhr | Demo 1: Proxmox für Ein- und Umsteiger In 15 Minuten zeigen wir Ihnen die Oberfläche und die wichtigsten Features. Sie werden sehen: Virtualisierung muss nicht kompliziert sein. Wir nehmen die Berührungsängste und zeigen, warum der Wechsel leichter ist, als man denkt.

- 10:20 Uhr | Demo 2: Das Proxmox-Ökosystem – Mehr als nur Hypervisor Was geht noch? Wir werfen einen Blick auf ProxLB, Pegaprox und das Thema Automatisierung. In 15 Minuten zeigen wir Ihnen, wie Sie das Maximum aus dem System herausholen.

- 10:40 Uhr – 12:00 Uhr | Offene Runde & Diskussion Der Rest des Vormittags gehört Ihnen. Fragen, Fachsimpeln oder einfach nur die Brötchen genießen.

Das Buffet: Kraftfutter für IT-Entscheider

Gute Ideen brauchen Energie. Deshalb sorgen wir für die passende Verpflegung:

- Frisch gebrühter Kaffee & Kaltgetränke.

- Eine Auswahl an frischen Brötchen.

- Das Highlight: Echter „Rheinischer Kaviar“ (für alle Nicht-Rheinländer: frische Mettbrötchen mit Zwiebeln). Keine Sorge, für vegetarische Alternativen ist natürlich ebenfalls gesorgt!

Alle Eckdaten auf einen Blick

- Wann: 19. März | 09:30 – 12:00 Uhr

- Wo: credativ GmbH, Hennes-Weisweiler-Allee 23, 41179 Mönchengladbach

- Für wen: Vom IT-Entscheider bis zum neugierigen Einsteiger – alle sind willkommen.

Anmeldung & Details

Damit wir die Mett-Produktion und die Brötchen-Logistik planen können, melden Sie sich bitte kurz über unsere Event-Seite an:

👉 Hier anmelden: https://luma.com/gvxo673b

Wir freuen uns auf einen lockeren Vormittag und spannende Gespräche mit Ihnen!

Rückblick auf den Dutch Proxmox Day 2025

Am 25. September 2025 waren wir beim Dutch Proxmox Day 2025 in Ede (Niederlande) – und ich darf sagen: die Veranstaltung war rundum gelungen. Organisiert von Tuxis B.V. im Hotel Belmont in der Veluwe-Region, bot der Tag eine ausgezeichnete Mischung aus Fachvorträgen und wertvollem Austausch.

Dank an die Gastgeber

Ein herzliches Dankeschön an das Tuxis-Team: Für die Einladung als Speaker, für das entgegengebrachte Vertrauen und für die perfekte Organisation. Ja — dieser Blogartikel kommt etwas später, aber wie man sagt: besser spät als nie.

Meine Perspektive als Speaker

Als Speaker hatte ich das Vergnügen, Teil eines spannenden Programms zu sein. Gleichzeitig war ich Teilnehmer: beides zugleich – das macht solche Tage besonders. Einige Vorträge möchte ich hervorheben:

- Aaron Lauterer (Linux Software Developer bei Proxmox Server Solutions) – „Let’s get technical with a Proxmox developer“: Ein Blick auf kommende Features von Proxmox VE. Besonders spannend die kommende Integration von OCI Containern (aka Docker).

- Rob Turk (Senior Presales Systems Engineer bei Veeam) – „Save the data“: Zeigt deutlich, das Proxmox mittlerweile in der Enterprise Welt angekommen ist.

- Mark Schouten (CTO bei Tuxis) – „Cool stuff you can do with Proxmox“: Proxmox Backup Server im Zusammenspiel mit ZFS wie man das ganze noch was performanter bekommt und was für unerwartete Probleme mit SCSI und Western Digital aufgetreten sind davon hat uns Mark Schouten erzählt

- Alexander Wirt – „Balancing workloads in Proxmox“: Mein eigener Beitrag mit Fokus auf das Projekt ProxLB meines werten Kollegen Florian Hoberg, das virtuelle Maschinen gleichmäßig über Knoten verteilt, zeigt wieder die Vorteile und OSS und offenen Schnittstellen. Diese ermöglichen es fehlende Funktionalität einfach zu ergänzen und damit auch den Branchengrößen Konkurrenz zu machen.

- Robbe Van Herck (Support & Maintenance Engineer bei International Polar Foundation) – „Proxmox on Antarctica“: Proxmox im Extrem-Einsatz – am anderen Ende der Welt und sehr fern vom üblichen Rechenzentrumsalltag. Robbe konnte gut zeigen das Proxmox auch in den abgelegensten Winkeln der Erde funktioniert, spannend sind hier eher die anderen Herausforderungen – wie Hardware die mit den niedrigen Temperaturen überfordert ist.

- Han Wessels (Operations System Engineer bei ESA) – „Challenged to run Proxmox out of this world“: Warum Proxmox auch auf der ISS oder im All betrieben werden kann – Technik trifft Vision. Han schilderte plastisch die Herausforderungen die dabei entstehen, wie z.B. die Vibration beim Start der Trägerrakete oder die Strahlung die die Lebensdauer von Speicher deutlich verkürzt.

Ich konnte viele Impulse mitnehmen – sowohl technisch als auch ideell. Und ich habe gute Gespräche geführt, die sich sicherlich noch weiter auszahlen werden.

Networking & Austausch

Der informelle Teil war genauso wertvoll wie das Programm: in den Pausen, beim Mittagessen oder beim Get-together am Nachmittag haben wir neue Kontakte geknüpft, interessante Einblicke erhalten und alte Bekannte getroffen. Genau diese Momente machen eine Tagung lebendig.

Ausblick

Wir freuen uns jetzt schon auf nächstes Jahr. Wenn das Tuxis-Team wieder ruft, sind wir gern wieder mit dabei. Nochmals vielen Dank an alle Beteiligten, alle Speaker und alle Teilnehmenden – auf ein Wiedersehen. Zwischendurch gibt es in diesem Dezember das erste Open Source Virtualization Gathering bei uns im Haus.

NetApp-Speicher und NVMe-oF für bahnbrechende Leistung in Proxmox-Virtualisierungsumgebungen

Was ist NVMe-oF

NVMe over Fabrics (NVMe-oF) ist ein hochmodernes Protokoll, das entwickelt wurde, um die beeindruckende Leistung und die geringe Latenz von NVMe-Speichergeräten über Netzwerk-Fabrics zu übertragen. Diese Innovation ist besonders transformativ für Rechenzentren, da sie die Trennung von Speicher- und Rechenressourcen ermöglicht, wodurch Administratoren die Möglichkeit erhalten, diese Ressourcen flexibler und mit größerer Skalierbarkeit bereitzustellen, was es perfekt für Virtualisierungs-Workloads macht.

NVMe-oF ist vielseitig in seiner Unterstützung für mehrere Transportschichten, wo es über Fibre Channel (FC), Ethernet mit dem TCP/IP-Protokoll mit RDMA-Funktionen über RoCE oder iWARP und sogar InfiniBand betrieben werden kann, wobei jede einzigartige Leistungsmerkmale bietet, die auf unterschiedliche Bereitstellungsanforderungen zugeschnitten sind.

NVMe-oF über TCP

Wenn NVMe-oF über Ethernet mit TCP bereitgestellt wird, bringt es die Vorteile von NVMe-Speicher in die größtmögliche Bandbreite von Umgebungen, ohne dass eine spezialisierte Netzwerkinfrastruktur wie Fibre Channel oder InfiniBand erforderlich ist. Dies ermöglicht den Zugriff auf Hochleistungsspeicher durch die Nutzung des gängigen und vertrauten TCP-Stacks, wodurch Komplexität und Kosten erheblich reduziert werden. Die Einführung von NVMe-oF mit TCP wird durch die weite Verbreitung von Ethernet und Fachwissen weiter erleichtert, was es zu einer überzeugenden Wahl für Unternehmen macht, die ihre Speichernetzwerke ohne eine komplette Überarbeitung aufrüsten möchten.

Die Effizienz des Protokolls bleibt auch über TCP gut erhalten, wodurch NVMe-Befehle mit minimalem Overhead übergeben werden können, was die Latenz gering hält und für latenzempfindliche Anwendungen wie virtualisierte Datenserver entscheidend ist.

NetApp-Speicher konfigurieren

Allgemein

Der Leitfaden setzt voraus, dass Benutzer die grundlegende Speichereinrichtung bereits vorgenommen haben, einschließlich der Konfiguration von Storage Virtual Machines (SVMs). Er hebt hervor, dass die Verwaltung dieser Systeme dank der intuitiven Weboberfläche, die von NetApp-Speichersystemen bereitgestellt wird, relativ unkompliziert ist. Benutzer können eine benutzerfreundliche Erfahrung bei der Verwaltung ihrer Speicherlösungen erwarten, da die Weboberfläche darauf ausgelegt ist, komplexe Aufgaben zu vereinfachen. Dies umfasst auch die gesamte Einrichtung für NVMe-oF-Speicher, was erfordert, NVMe generell auf der SVM zu aktivieren, den NVMe-Namespace und das NVMe-Subsystem einzurichten.

Hinweis: Alle Änderungen können selbstverständlich auch automatisiert durch Orchestrierung der OnTap API vorgenommen werden.

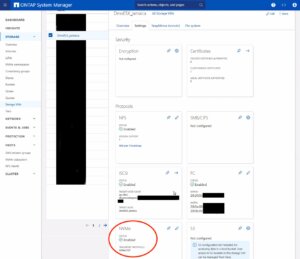

NVMe auf SVM aktivieren

Um NVMe auf SVM-Ebene in einem NetApp-Speichersystem zu aktivieren, kann dies typischerweise durch Befolgen dieser zusammengefassten Schritte erfolgen, die über die Weboberfläche des Systems zugänglich sind. Navigieren Sie einfach zum Menü Storage, dann zu Storage VMs und wählen Sie schließlich den spezifischen SVM-Namen aus, den Sie konfigurieren möchten:

Um NVMe auf SVM-Ebene in einem NetApp-Speichersystem zu aktivieren, kann dies typischerweise durch Befolgen dieser zusammengefassten Schritte erfolgen, die über die Weboberfläche des Systems zugänglich sind. Navigieren Sie einfach zum Menü Storage, dann zu Storage VMs und wählen Sie schließlich den spezifischen SVM-Namen aus, den Sie konfigurieren möchten:

- NVMe-Protokoll konfigurieren: Suchen Sie innerhalb der SVM-Einstellungen nach einem Abschnitt oder Tab, der sich auf Protokolle bezieht. Suchen Sie die NVMe-Option und aktivieren Sie sie. Dies kann das Aktivieren eines Kontrollkästchens oder das Umschalten eines Schalters in die Position ‚Ein‘ beinhalten.

- Änderungen speichern und anwenden: Nachdem Sie NVMe aktiviert haben, stellen Sie sicher, dass Sie die Änderungen speichern. Es können zusätzliche Aufforderungen oder Schritte zur Bestätigung der Änderungen erforderlich sein, abhängig vom spezifischen NetApp-System und seiner Version.

Denken Sie daran, alle Voraussetzungen oder zusätzlichen Konfigurationseinstellungen zu prüfen, die für den NVMe-Betrieb erforderlich sein könnten, wie Netzwerkeinstellungen, Lizenzierung oder Kompatibilitätsprüfungen der Hardware. Die genauen Schritte können je nach ONTAP-Version oder dem spezifischen NetApp-Modell, das Sie verwenden, leicht variieren. Beziehen Sie sich immer auf die neueste offizielle NetApp-Dokumentation oder Support-Ressourcen für die genaueste Anleitung.

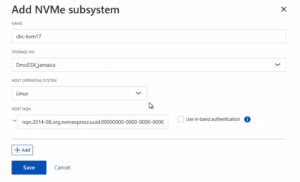

Das NVMe-Subsystem erstellen

Anschließend kann ein neues NVMe-Subsystem auf dem NetApp-Speichersystem erstellt werden. Dies kann durch Auswahl des Abschnitts Hosts und Auswahl von NVMe Subsystem erfolgen, um den Prozess des Hinzufügens eines neuen Subsystems zu starten. Ein neuer Assistent öffnet sich, der zusätzliche Informationen zum neu zu erstellenden Subsystem erfordert:

Name: <Ein Bezeichner des NVMe-Subsystems>

Name: <Ein Bezeichner des NVMe-Subsystems>

Storage VM: <Die zuvor angepasste SVM>

Host-Betriebssystem: Linux (wichtig für die Blockgröße)

Host NQN: <NQN des Proxmox VE-Knotens>

Es ist unerlässlich sicherzustellen, dass alle Informationen, insbesondere der Host-NQN, korrekt eingegeben werden, um Konnektivitätsprobleme zu vermeiden. Konsultieren Sie zusätzlich die offizielle NetApp-Dokumentation für versionsspezifische Anweisungen oder zusätzliche Konfigurationsschritte, die erforderlich sein könnten.

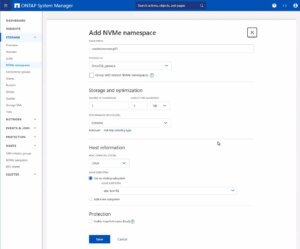

Den NVMe-Namespace erstellen

Als letzten Schritt muss der NVMe-Namespace erstellt werden. Um einen NVMe-Namespace auf einem NetApp-Speichersystem hinzuzufügen, melden Sie sich zunächst bei der Weboberfläche an und navigieren Sie zum Abschnitt Storage, gefolgt von der Auswahl von NVMe Namespaces. In diesem Bereich initiieren Sie den Prozess der Erstellung eines neuen Namespace. Sie werden aufgefordert, spezifische Details für den Namespace anzugeben, wie seinen Namen, seine Größe und die zugehörige SVM, die ihn verwalten wird.

Als letzten Schritt muss der NVMe-Namespace erstellt werden. Um einen NVMe-Namespace auf einem NetApp-Speichersystem hinzuzufügen, melden Sie sich zunächst bei der Weboberfläche an und navigieren Sie zum Abschnitt Storage, gefolgt von der Auswahl von NVMe Namespaces. In diesem Bereich initiieren Sie den Prozess der Erstellung eines neuen Namespace. Sie werden aufgefordert, spezifische Details für den Namespace anzugeben, wie seinen Namen, seine Größe und die zugehörige SVM, die ihn verwalten wird.

Hinweis: Beachten Sie auch einen wichtigen Hinweis zum Performance Service Level, der möglicherweise auf ein benutzerdefiniertes Profil umgestellt werden sollte, um Einschränkungen zu vermeiden.

Sobald Sie alle erforderlichen Informationen eingegeben haben, werden Sie typischerweise fortfahren, die Leistungsmerkmale auszuwählen, wie das Service Level oder die Tiering-Richtlinie, abhängig von Ihren Leistungsanforderungen und den Fähigkeiten Ihres NetApp-Systems.

Nachdem Sie diese Einstellungen konfiguriert haben, müssen Sie Ihre Auswahl überprüfen und die neue Namespace-Konfiguration speichern, um sie zur Verwendung verfügbar zu machen. Es ist wichtig sicherzustellen, dass der Namespace ordnungsgemäß konfiguriert ist, um den Anforderungen Ihrer Umgebung für optimale Leistung und Kompatibilität zu entsprechen. Überprüfen Sie immer auf zusätzliche Schritte oder Voraussetzungen, indem Sie die NetApp-Dokumentation konsultieren, die für Ihre ONTAP-Version oder Ihr Speichermodell relevant ist.

Die Konfiguration auf der Speicherseite ist nun abgeschlossen. Die nächsten Schritte werden auf dem/den Proxmox VE-Knoten durchgeführt.

Proxmox-Knoten konfigurieren

Allgemein

Nach der Konfiguration der NetApp-Speicherappliance müssen alle Proxmox VE-Knoten innerhalb des Clusters für die Nutzung und den Zugriff auf den NVMe-oF-Speicher konfiguriert werden. Leider unterstützt Proxmox VE diese Art von Speicher nicht von Haus aus. Daher kann dies nicht einfach über die Proxmox-Weboberfläche konfiguriert werden. Glücklicherweise basiert Proxmox VE auf Debian Linux, von wo aus alle benötigten Abhängigkeiten und Konfigurationen bezogen werden können, aber es erfordert, dass wir alles über die Kommandozeile (CLI) erledigen. Abhängig von der Anzahl der Knoten innerhalb des Clusters können weitere Konfigurationsmanagement-Tools wie Ansible den anfänglichen Einrichtungsprozess beschleunigen und für neue potenzielle Knoten in der Zukunft wiederholbar machen. Wir können Sie auch bei der Einrichtung maßgeschneiderter Konfigurationsmanagement-Umgebungen unterstützen, die Ihren Anforderungen entsprechen.

Im Allgemeinen besteht dieser Prozess aus:

- Erforderliche Pakete installieren.

- Die Kernel-Module aktivieren.

- Erkennung des Speichers.

- Verbindung mit dem Speicher herstellen.

- Eine LVM-Volume-Gruppe erstellen.

- Den Speicher in der Proxmox-Weboberfläche zuweisen.

Die nächsten Schritte in diesem Blogbeitrag werden den Prozess detailliert behandeln und Sie durch die erforderlichen Schritte auf den Proxmox VE-Knoten führen, die auf der Kommandozeile ausgeführt werden müssen.

Erforderliche Pakete installieren

Die Nutzung und der Zugriff auf NVMe-oF erfordert, dass die zugehörigen User-Land-Tools (nvme-cli) auf dem Proxmox VE-Knoten vorhanden sind. Debian Linux stellt diese Tools bereits im Debian-Repository bereit. Daher ist der gesamte Installationsprozess sehr einfach. Das Paket kann einfach mit dem folgenden Befehl installiert werden:

apt-get install nvme-cli

Dieses Paket stellt auch bereits das erforderliche Kernel-Modul bereit, das einfach durch Ausführen von geladen werden kann:

modprobe nvme_tcp

Anschließend sollte das Modul hinzugefügt werden, um beim Booten geladen zu werden:

echo "nvme_tcp" > /etc/modules-load.d/20-nvme_tcp.conf

Nach diesen Schritten kann eine Verbindung mit dem Speicher initialisiert werden.

Verbindung mit dem Speicher herstellen

Die Interaktion mit dem NetApp-Speicher und seiner NVMe-oF-Funktionalität ist ein mehrstufiger Prozess und erfordert den Austausch der NVMe Qualified Name (NQN)-Adresse jedes Proxmox VE-Knotens, der auf den NVMe-Speicher zugreift. Die NQN-Adresse eines Proxmox VE-Knotens kann durch Ausführen des Befehls abgerufen werden:

cat /etc/nvme/hostnqn

![]()

Fügen Sie die Host-NQN-Adresse zu Ihrem NetApp-Export hinzu, um den Knoten den Zugriff darauf zu ermöglichen. Eine Beispielausgabe ist im Screenshot angegeben.

Erkennung & Verbindung

Im nächsten Schritt werden die NVMe-Geräte erkannt und mit dem Proxmox VE-Knoten verbunden. Der Erkennungs- und Verbindungsprozess erfolgt einfach durch Ausführen der folgenden Befehle:

nvme discover -t tcp -a 192.168.164.100 -s 4420

nvme connect -t tcp -n na01-nqn01 -a 192.168.164.100 -s 4420

Um diese Konfiguration systemneustartfest zu machen, werden die Befehle auch zur nvme-Discovery-Datei hinzugefügt. Die nvmf-autoconnect systemd-Unit-Datei stellt sicher, dass dies geladen wird. Daher muss diese systemd-Unit-Datei ebenfalls aktiviert werden.

echo "discover -t tcp -a 192.168.164.100 -s 4420" >> etc/nvme/discovery.conf

systemctl enable nvmf-autoconnect.service

Volume-Gruppe

Die letzten Schritte werden teilweise auf der Kommandozeile und teilweise über die Proxmox-Weboberfläche durchgeführt, um den neuen Speicher zum Cluster hinzuzufügen.

Wichtig:

Diese Schritte dürfen nur auf einem einzelnen Proxmox VE Host-Knoten und nicht auf allen durchgeführt werden. Die Integration erfolgt auf Clusterebene und betrifft alle Proxmox VE-Knoten, sobald dies geschehen ist.

Der letzte Befehl auf der Kommandozeile führt zur Erstellung einer neuen LVM Volume Group (VG) auf dem neuen NVMe-Gerät, was einfach durch Ausführen des Befehls geschehen kann:

vgcreate shared_nvme01 /dev/nvme0n1

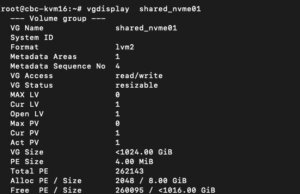

Die neu erstellte LVM Volume Group (VG) kann durch Ausführen des Befehls validiert werden:

vgdisplay shared_nvme01

Eine Ausgabe wie im angegebenen Screenshot sollte zurückgegeben werden, einschließlich aller weiteren Details dieser VG. Nach der Validierung der Informationen sind alle Aufgaben auf der Kommandozeile abgeschlossen.

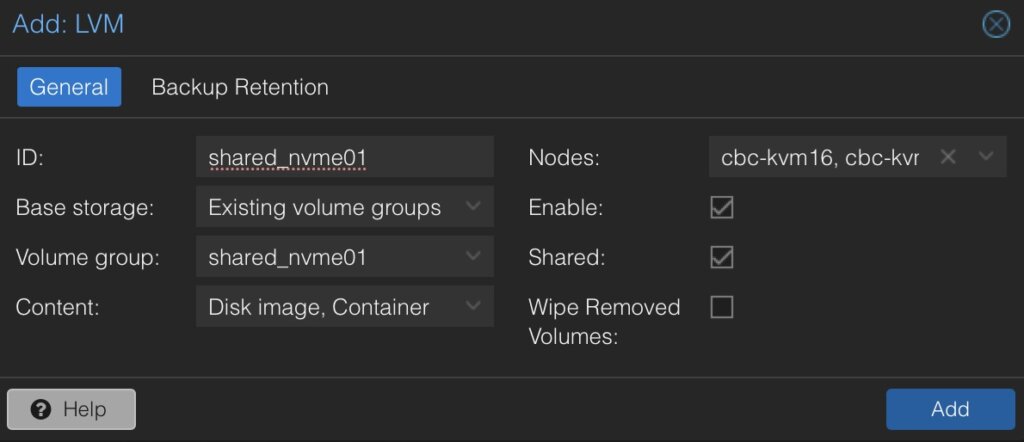

Um diese LVM Volume Group schließlich auf allen Proxmox VE-Knoten innerhalb des Clusters zu verwenden, muss diese Volume Group auf Clusterebene hinzugefügt und integriert werden. Dazu müssen wir uns im Web-Frontend des Clusters anmelden und dies unter hinzufügen:

- Datacenter

- Storage

- Hinzufügen

- LVM

Im neuen Fenster müssen weitere Details für den neuen LVM-Speicher definiert werden:

- ID: shared_nvme01 (dies kann beliebiger Text sein und ist lediglich ein Bezeichner)

- Basisspeicher: Bestehende Volume-Gruppen

- Volume-Gruppe: shared_nvme01

- Inhalt: Disk-Image, Container (kann variieren)

- Knoten: <Wählen Sie alle Knoten aus, die es verwenden sollen>

- Aktiviert: Ja

- Freigegeben: Ja

- Entfernte Volumes löschen: Nein

Durch Klicken auf Hinzufügen wird dies als neues Volume an die ausgewählten Knoten angehängt und kann direkt verwendet werden.

Fazit

Die Nutzung von NVMe over Fabrics (NVMe-oF) über TCP in Verbindung mit Proxmox VE in einer Virtualisierungsumgebung stellt eine überzeugende Lösung für Organisationen dar, die kostengünstige und dennoch hochleistungsfähige Speicherarchitekturen suchen. Dieser Ansatz nutzt die weite Verbreitung und Kompatibilität von Ethernet-basierten Netzwerken, wodurch die Notwendigkeit spezialisierter Hardware wie Fibre Channel oder InfiniBand vermieden wird, die für viele Unternehmen kostenintensiv sein kann.

Durch die Integration von NVMe-oF mit Proxmox, einer beliebten Open-Source-Virtualisierungsplattform, können Benutzer von deutlich verbesserten Datenübertragungsgeschwindigkeiten und geringerer Latenz im Vergleich zu traditionellen Speicherlösungen profitieren. NVMe-oF kann nicht nur mit Proxmox VE, sondern auch auf anderen Betriebssystemen wie FreeBSD und Hypervisoren wie bhyve verwendet werden. Dies bietet einen großen Vorteil für latenzempfindliche Workloads, wie virtualisierte Datenbankserver, wo schneller Datenzugriff für die Leistung entscheidend ist. Das NVMe-Protokoll ist darauf ausgelegt, das volle Potenzial von Solid-State-Speichertechnologien auszuschöpfen. Bei Verwendung über ein Netzwerk-Fabric mittels TCP kann es eine nahezu lokale NVMe-Leistung liefern, indem es sehr kostengünstig ist.

Gerne stehen wir Ihnen zur Verfügung, um weitere Einblicke in NetApp-Speichersysteme zu geben, die sowohl Hardware- als auch Softwareaspekte abdecken. Unsere Expertise erstreckt sich auch auf Open-Source-Produkte, insbesondere bei der Einrichtung von Virtualisierungsumgebungen mit Technologien wie Proxmox und OpenShift oder deren Wartung mit Konfigurationsmanagement. Wir laden Sie ein, sich bei Bedarf an uns zu wenden.

Es könnte Sie auch interessieren zu erfahren, wie Sie VMs von VMware ESXi zu Proxmox VE migrieren oder wie Sie den Proxmox Backup Server in Ihre Infrastruktur integrieren können.

Integration des Proxmox Backup Servers in Proxmox-Cluster

Proxmox Backup Server

In der heutigen digitalen Landschaft, in der Daten die zentrale Rolle spielen, ist die Gewährleistung ihrer Sicherheit und Integrität für Unternehmen jeder Größe von größter Bedeutung. Hier kommt der Proxmox Backup Server ins Spiel, eine robuste Lösung, die mit ihren beispiellosen Funktionen und ihrem Open-Source-Charakter die Datensicherungsstrategien revolutionieren wird.

Im Kern ist der Proxmox Backup Server eine umfassende Backup-Lösung, die entwickelt wurde, um kritische Daten und Anwendungen in virtualisierten Umgebungen auf Basis von Proxmox VE mühelos zu schützen. Im Gegensatz zu herkömmlichen Backup-Methoden bietet der Proxmox Backup Server einen optimierten Ansatz, der die mit Datensicherung und -wiederherstellung verbundenen Komplexitäten vereinfacht.

Eines der herausragenden Merkmale des Proxmox Backup Servers ist seine nahtlose Integration mit der Proxmox Virtual Environment (PVE), wodurch ein kohärentes Ökosystem für die Verwaltung virtualisierter Umgebungen entsteht. Diese Integration ermöglicht eine effiziente Sicherung und Wiederherstellung von Linux-Containern und virtuellen Maschinen, was minimale Ausfallzeiten und maximale Produktivität gewährleistet. Ohne die Notwendigkeit von Backup-Clients auf jedem Container oder jeder virtuellen Maschine bietet diese Lösung dennoch die Möglichkeit, das gesamte System sowie einzelne Dateien direkt aus dem Dateisystem zu sichern und wiederherzustellen.

Der Proxmox Backup Server bietet eine benutzerfreundliche Oberfläche, die ihn sowohl für erfahrene IT-Profis als auch für Neueinsteiger zugänglich macht. Mit seinem intuitiven Design können Benutzer Backup-Aufgaben einfach konfigurieren, den Fortschritt überwachen und Daten mit nur wenigen Klicks abrufen, wodurch umfangreiche Schulungen oder technisches Fachwissen überflüssig werden.

Datensicherheit hat für Unternehmen aller Branchen oberste Priorität, und der Proxmox Backup Server erfüllt diese Anforderung. Gebündelt mit Lösungen wie ZFS bietet er alle Enterprise-Dateisystemfunktionen wie Verschlüsselung im Ruhezustand, Verschlüsselung während der Übertragung, Prüfsummen, Snapshots, Deduplizierung und Komprimierung. Zudem kann die Integration von iSCSI– oder NFS-Speicher aus Enterprise-Speicherlösungen wie von NetApp genutzt werden.

Ein weiterer bemerkenswerter Aspekt des Proxmox Backup Servers ist seine Kosteneffizienz. Als Open-Source-Lösung beseitigt er die finanziellen Barrieren (auch in Verbindung mit den Proxmox VE-Lösungen), die mit proprietärer Backup-Software verbunden sind.

Integration des Proxmox Backup Servers in Proxmox-Cluster

Allgemein

Dieser Leitfaden setzt voraus, dass Sie bereits mindestens ein Proxmox VE-System in Betrieb haben und auch ein System, auf dem eine grundlegende Installation des Proxmox Backup Servers durchgeführt wurde. In diesem Beispiel ist der Proxmox Backup Server auf einer einzelnen Festplatte installiert, wobei der Datenspeicher an ein zusätzliches Blockgerät angehängt wird, das die Backups enthält. Proxmox VE- und Proxmox Backup Server-Instanzen müssen sich nicht im selben Netzwerk befinden, müssen aber gegenseitig erreichbar sein. Die Integration erfordert administrativen Zugriff auf das Datacenter der Proxmox VE-Instanz(en) und den Backup Server.

Voraussetzungen

- Proxmox VE (einschließlich des Datacenters).

- Proxmox Backup Server (Basisinstallation).

- Administrativer Zugriff auf alle Systeme.

- Netzwerkerreichbarkeit.

- Speichergerät, das die Backups enthält (in diesem Fall ein dediziertes Block-Speichergerät).

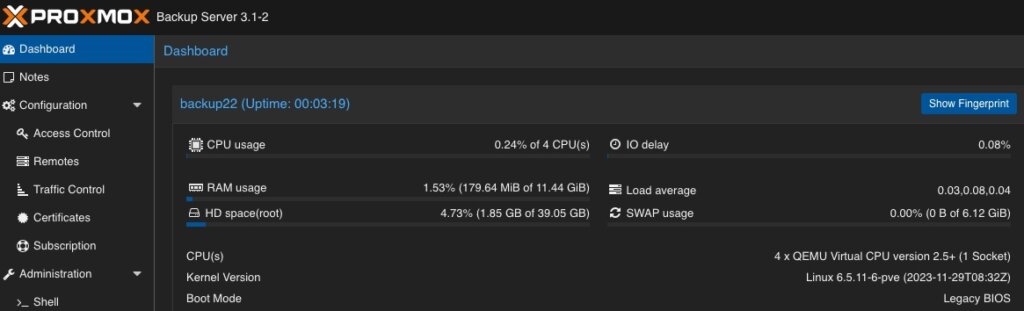

Administration: Proxmox Backup Server

Wie die Proxmox VE-Umgebung verfügt auch der Proxmox Backup Server über ein sehr intuitives Web-Frontend. Im Gegensatz zum Web-Frontend von Proxmox VE, das auf tcp/8006 läuft, ist der Proxmox Backup Server auf tcp/8007 erreichbar. Daher werden alle nächsten Aufgaben unter https://<IP-PROXMOX-BACKUP-SERVER>:8007 durchgeführt.

Nach der Anmeldung am Web-Frontend begrüßt die Dashboard-Übersicht den Benutzer.

Datenspeicher hinzufügen / Speicher verwalten

Die anfänglichen und wichtigsten Aufgaben bestehen darin, den Speicher zu verwalten und einen nutzbaren Datenspeicher für die Virtualisierungsumgebung hinzuzufügen, der die Backup-Daten enthält. Daher wechseln wir zum Kapitel Administration und klicken auf Speicher / Festplatten. Dies bietet eine Übersicht über die verfügbaren Geräte auf dem Proxmox Backup Server.  Wie bereits erwähnt, verwendet dieses Beispiel ein dediziertes Block-Speichergerät, das mit ZFS genutzt wird, um von Prüfsummen, Deduplizierung und Komprimierung zu profitieren, was natürlich auch zusätzlich mit mehreren Festplatten (sogenannten raidz-Levels) oder mit anderen Lösungen wie Ordner- oder NFS-Freigaben verwendet werden kann. Zurück zu unserem Beispiel sehen wir das leere /dev/sdb-Gerät, das zum Speichern aller Backup-Dateien verwendet wird.

Wie bereits erwähnt, verwendet dieses Beispiel ein dediziertes Block-Speichergerät, das mit ZFS genutzt wird, um von Prüfsummen, Deduplizierung und Komprimierung zu profitieren, was natürlich auch zusätzlich mit mehreren Festplatten (sogenannten raidz-Levels) oder mit anderen Lösungen wie Ordner- oder NFS-Freigaben verwendet werden kann. Zurück zu unserem Beispiel sehen wir das leere /dev/sdb-Gerät, das zum Speichern aller Backup-Dateien verwendet wird.

Durch Klicken auf ZFS in der oberen Menüleiste kann ein ZFS-Pool als Datenspeicher erstellt werden. Dabei müssen ein Name, der RAID-Level, die Komprimierung und die zu verwendenden Geräte definiert werden.  Wie bereits erwähnt, können wir mehrere Festplatten anschließen und einen gewünschten RAID-Level definieren. Das gegebene Beispiel besteht nur aus einer einzelnen Festplatte, die hier definiert wird. Komprimierung ist optional, aber die Verwendung von LZ4 als Komprimierung wird empfohlen. Als verlustfreier Datenkompressionsalgorithmus zielt LZ4 darauf ab, einen guten Kompromiss zwischen Geschwindigkeit und Kompressionsrate zu bieten, was auf heutigen Systemen sehr transparent ist.

Wie bereits erwähnt, können wir mehrere Festplatten anschließen und einen gewünschten RAID-Level definieren. Das gegebene Beispiel besteht nur aus einer einzelnen Festplatte, die hier definiert wird. Komprimierung ist optional, aber die Verwendung von LZ4 als Komprimierung wird empfohlen. Als verlustfreier Datenkompressionsalgorithmus zielt LZ4 darauf ab, einen guten Kompromiss zwischen Geschwindigkeit und Kompressionsrate zu bieten, was auf heutigen Systemen sehr transparent ist.

Stellen Sie sicher, dass die Option Als Datenspeicher hinzufügen (Standard) aktiviert ist, da dies den angegebenen Namen direkt als nutzbaren Datenspeicher erstellt. In unserem Beispiel wird dies backup01 sein.

Beachten Sie, dass dieser Teil nicht erforderlich ist, wenn Sie eine NFS-Freigabe verwenden. Verwenden Sie dies auch nicht in Verbindung mit Hardware-RAID-Controllern.

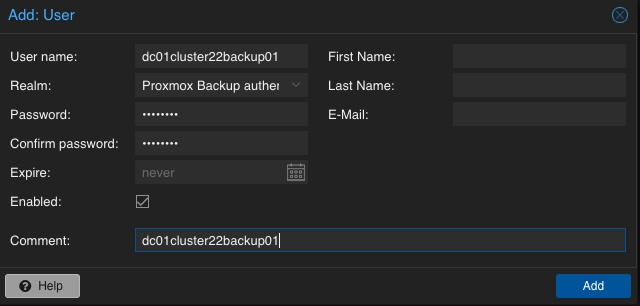

Benutzer für Backup hinzufügen

Im nächsten Schritt wird ein dedizierter Benutzer erstellt, der für die Datenspeicherberechtigungen und für die Proxmox VE-Instanzen zur Authentifizierung und Autorisierung verwendet wird. Dies ermöglicht selbst komplexe Setups mit verschiedenen Datenspeichern, verschiedenen Benutzern einschließlich unterschiedlicher Zugriffsebenen (z. B. Lesen, Schreiben, Auditieren,…) auf verschiedenen Clustern und Instanzen. Um es für Demonstrationen einfach zu halten, wird nur ein einziger Benutzer für alles verwendet.

Ein neuer Benutzer wird konfiguriert, indem Sie im linken Menü Konfiguration, Zugriffssteuerung und Benutzerverwaltung auswählen. Dort kann ein neuer Benutzer durch einfaches Definieren eines Namens und eines Passworts erstellt werden. Der Standard-Realm sollte für den Proxmox Backup-Authentifizierungsanbieter auf dem Standardwert bleiben. Je nach Komplexität des verwendeten Namensschemas können Sie auch sinnvolle Benutzer erstellen. Im gegebenen Beispiel heißt der Benutzer dc01cluster22backup01.

Ein neuer Benutzer wird konfiguriert, indem Sie im linken Menü Konfiguration, Zugriffssteuerung und Benutzerverwaltung auswählen. Dort kann ein neuer Benutzer durch einfaches Definieren eines Namens und eines Passworts erstellt werden. Der Standard-Realm sollte für den Proxmox Backup-Authentifizierungsanbieter auf dem Standardwert bleiben. Je nach Komplexität des verwendeten Namensschemas können Sie auch sinnvolle Benutzer erstellen. Im gegebenen Beispiel heißt der Benutzer dc01cluster22backup01.

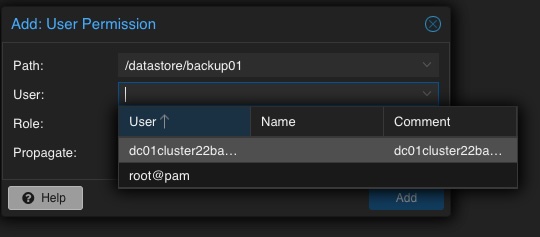

Berechtigung des Benutzers für Datenspeicher hinzufügen

Angesichts der bereits erwähnten Möglichkeit, komplexe Setups bezüglich Authentifizierung und Autorisierung zu erstellen, muss der Datenspeicher mindestens einem einzelnen Benutzer zugeordnet werden, der darauf zugreifen kann. Daher kehren wir zum Datenspeicher zurück und wählen den zuvor erstellten backup01-Datenspeicher aus. In der oberen Menüleiste können die Berechtigungen im Kapitel Berechtigungen erstellt und angepasst werden. Zunächst wird nun eine neue erstellt. In der folgenden Übersicht müssen der Datenspeicher oder Pfad, der Benutzer und die Rolle definiert werden:

Pfad: /datastore/backup01

Benutzer: dc01cluster22backup01@pbs

Rolle: DatastoreAdmin

Propagieren: True

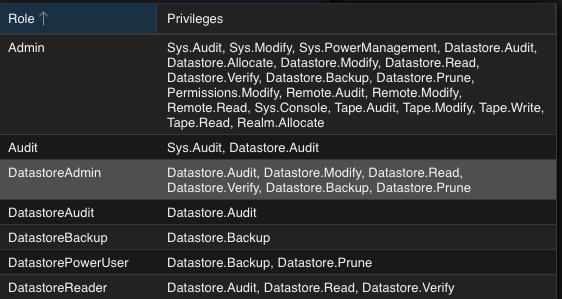

Um einen kurzen Überblick über die möglichen Rollen zu geben, wird dies kurz ohne weitere Erläuterung erwähnt:

- Admin

- Audit

- DatastoreAdmin

- DatastoreAudit

- DatastoreBackup

- DatastorePowerUser

- DatastoreReader

Administration: Proxmox VE

Die Integration des Backup-Datenspeichers wird von den Proxmox VE-Instanzen über das Datacenter durchgeführt. Infolgedessen wird das Proxmox VE Web-Frontend nun für weitere administrative Aktionen verwendet. Das Proxmox VE Web-Frontend läuft auf tcp/8006. Daher werden alle nächsten Aufgaben unter https://<IP-PROXMOX-VE-SERVER>:8006 durchgeführt.

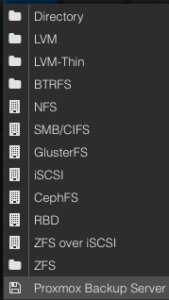

Speicher hinzufügen

Die Integration des Proxmox Backup Servers funktioniert auf die gleiche Weise wie die Verwaltung und das Hinzufügen eines freigegebenen Speichers zu einem Proxmox-Datacenter.

Die Integration des Proxmox Backup Servers funktioniert auf die gleiche Weise wie die Verwaltung und das Hinzufügen eines freigegebenen Speichers zu einem Proxmox-Datacenter.

Im linken Menü wählen wir das aktive Datacenter aus und wählen die Speicher-Optionen. Dort finden wir alle nativ unterstützten Speicheroptionen von Proxmox (wie NFS, SMB/CIFS, iSCSI, ZFS, GlusterFS,…) und wählen schließlich den Proxmox Backup Server als dediziertes Element aus.

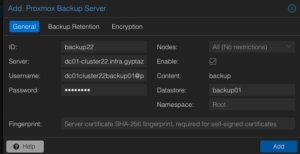

Anschließend müssen die Details zum Hinzufügen dieses Datenspeichers zum Datacenter eingegeben werden. Die folgenden Optionen müssen definiert werden:

ID: backup22

ID: backup22

Server: <FQDN-ODER-IP-DES-BACKUP-SERVERS>

Benutzername: dc01cluster22backup01@pbs

Passwort: <DAS-PASSWORT-DES-BENUTZERS>

Aktivieren: True

Datenspeicher: backup01

Fingerabdruck: <SYSTEM-FINGERABDRUCK-DES-BACKUP-SERVERS>

Optional können auch die Backup-Aufbewahrung und Verschlüsselung konfiguriert werden, bevor der neue Backup-Datenspeicher hinzugefügt wird. Während die Backup-Aufbewahrung auch auf dem Proxmox Backup Server konfiguriert werden kann (was empfohlen wird), sollte die Aktivierung der Verschlüsselung in Betracht gezogen werden. Das Auswählen und Aktivieren der Verschlüsselung erfolgt einfach durch die Einstellung auf Client-Verschlüsselungsschlüssel automatisch generieren. Je nach Ihrer vorherigen Einrichtung kann auch ein bereits vorhandener Schlüssel hochgeladen und verwendet werden.

Optional können auch die Backup-Aufbewahrung und Verschlüsselung konfiguriert werden, bevor der neue Backup-Datenspeicher hinzugefügt wird. Während die Backup-Aufbewahrung auch auf dem Proxmox Backup Server konfiguriert werden kann (was empfohlen wird), sollte die Aktivierung der Verschlüsselung in Betracht gezogen werden. Das Auswählen und Aktivieren der Verschlüsselung erfolgt einfach durch die Einstellung auf Client-Verschlüsselungsschlüssel automatisch generieren. Je nach Ihrer vorherigen Einrichtung kann auch ein bereits vorhandener Schlüssel hochgeladen und verwendet werden.

Nachdem dieser Backup-Datenspeicher zum Datacenter hinzugefügt wurde, kann dieser sofort für Backups verwendet werden und die Integration ist abgeschlossen.

Fazit

Proxmox bietet mit dem Proxmox Backup Server eine Enterprise-Backup-Lösung zur Sicherung von Linux-Containern und virtuellen Maschinen. Mit Funktionen wie inkrementellen und vollständig deduplizierten Backups, die die Vorteile verschiedener Open-Source-Lösungen nutzen, zusammen mit starker Verschlüsselung und Datenintegrität, ist diese Lösung ein Beweis dafür, dass Open-Source-Software mit proprietärer Unternehmenssoftware konkurrieren kann. Zusammen mit Proxmox VE können unternehmensähnliche Virtualisierungsumgebungen erstellt und verwaltet werden, ohne die typischen Enterprise-Funktionen zu vermissen. Proxmox VE und der Proxmox Backup Server können auch zusätzlich zu Speicher-Appliances von Anbietern wie NetApp verwendet werden, indem direkt iSCSI oder NFS genutzt wird.

Dieses einfache Beispiel dient als Grundlage, es gibt aber natürlich viel komplexere Szenarien, die erstellt und auch berücksichtigt werden sollten. Gerne stellen wir Ihnen weitere Informationen zur Verfügung und unterstützen Sie bei der Erstellung solcher Setups. Wir bieten auch Unterstützung bei der

Migration von VMs von VMware ESXi zu Proxmox

Als Reaktion auf Broadcoms jüngste Änderungen im Abonnementmodell von VMware überdenken immer mehr Unternehmen ihre Virtualisierungsstrategien. Angesichts erhöhter Bedenken hinsichtlich Lizenzkosten und Feature-Zugänglichkeit wenden sich Unternehmen open source Lösungen zu, um mehr Flexibilität und Kosteneffizienz zu erzielen.

Vorteile von Open-Source-Lösungen

In der dynamischen Landschaft des modernen Geschäftslebens stellt die Entscheidung für open source Lösungen für die Virtualisierung einen strategischen Vorteil für Unternehmen dar. Mit Plattformen wie KVM, Xen und sogar LXC-Containern können Unternehmen von der Abwesenheit von Lizenzgebühren profitieren, was erhebliche Kosteneinsparungen ermöglicht und Ressourcen in Innovation und Wachstum umleitet. Diese finanzielle Flexibilität ermöglicht es Unternehmen, strategische Investitionen in ihre IT-Infrastruktur zu tätigen, ohne die Belastung durch proprietäre Lizenzkosten. Darüber hinaus fördert die Open-Source-Virtualisierung die Zusammenarbeit und Transparenz, sodass Unternehmen ihre Umgebungen an ihre individuellen Bedürfnisse anpassen und nahtlos in bestehende Systeme integrieren können. Durch die Community-gesteuerte Entwicklung und robuste Support-Netzwerke erhalten Unternehmen Zugang zu einem reichen Wissens- und Ressourcenpool, der die Zuverlässigkeit, Sicherheit und Skalierbarkeit ihrer virtualisierten Infrastruktur gewährleistet. Die Nutzung der Open-Source-Virtualisierung bietet nicht nur greifbare finanzielle Vorteile, sondern stattet Unternehmen auch mit der Agilität und Anpassungsfähigkeit aus, die sie benötigen, um in einer sich ständig weiterentwickelnden digitalen Landschaft erfolgreich zu sein.

Migrieren einer VM

Voraussetzungen

Um einen reibungslosen Migrationsprozess von VMware ESXi zu Proxmox zu gewährleisten, müssen mehrere wichtige Schritte unternommen werden. Zunächst muss der SSH-Zugriff sowohl auf dem VMware ESXi-Host als auch auf dem Proxmox-Host aktiviert werden, um die Remote-Verwaltung und -Administration zu ermöglichen. Zusätzlich ist es entscheidend, Zugriff auf beide Systeme zu haben, um den Migrationsprozess zu erleichtern. Des Weiteren ist die Herstellung einer SSH-Verbindung zwischen VMware ESXi und Proxmox für eine nahtlose Kommunikation zwischen den beiden Plattformen unerlässlich. Dies gewährleistet eine effiziente Datenübertragung und -verwaltung während der Migration. Darüber hinaus ist es zwingend erforderlich, das Proxmox VE-System oder den Cluster ähnlich dem ESXi-Setup zu konfigurieren, insbesondere hinsichtlich der Netzwerkkonfigurationen. Dies beinhaltet die Sicherstellung der Kompatibilität mit VLANs oder VXLANs für komplexere Setups. Zusätzlich sollten beide Systeme entweder auf lokalem Speicher laufen oder Zugriff auf gemeinsamen Speicher, wie NFS, haben, um die Übertragung von virtuellen Maschinendaten zu erleichtern. Schließlich ist es vor Beginn der Migration unerlässlich zu überprüfen, ob das Proxmox-System über ausreichend verfügbaren Speicherplatz verfügt, um die importierte virtuelle Maschine aufzunehmen und so einen erfolgreichen Übergang ohne Speicherengpässe zu gewährleisten.

SSH auf ESXi aktivieren

Der SSH-Server muss aktiviert sein, um den Inhalt vom ESXi-System an den neuen Speicherort auf dem Proxmox-Server zu kopieren. Die virtuelle Maschine wird später auf den Proxmox-Server kopiert. Daher ist es notwendig, dass das Proxmox-System eine SSH-Verbindung über tcp/22 zum ESXi-System herstellen kann:

- Melden Sie sich beim VMware ESXi-Host an.

- Navigieren Sie zu Konfiguration > Sicherheitsprofil.

- Aktivieren Sie SSH unter Dienste.

Quellinformationen über VM auf ESXi finden

Eine der herausfordernden Aufgaben ist das Auffinden des Speicherorts der virtuellen Maschine, die die virtuelle Festplatte enthält. Der Pfad kann in der Web-UI des ESXi-Systems gefunden werden:

- Suchen Sie den ESXi-Knoten, auf dem die virtuelle Maschine ausgeführt wird, die migriert werden soll

- Identifizieren Sie die zu migrierende virtuelle Maschine (z. B. pgsql07.gyptazy.ch).

- Ermitteln Sie den Speicherort der virtuellen Festplatte (VMDK), die der VM zugeordnet ist, über das Konfigurationsfeld.

- Der VM-Speicherortpfad sollte angezeigt werden (z. B. /vmfs/volumes/137b4261-68e88bae-0000-000000000000/pgsql07.gyptazy.ch).

- VM stoppen und herunterfahren.

Eine neue leere VM auf Proxmox erstellen

- Erstellen Sie eine neue leere VM in Proxmox.

- Weisen Sie die gleichen Ressourcen wie im ESXi-Setup zu.

- Stellen Sie den Netzwerktyp auf VMware vmxnet3 ein.

- Stellen Sie sicher, dass die benötigten Netzwerkressourcen (z. B. VLAN, VXLAN) ordnungsgemäß konfiguriert sind.

- Stellen Sie den SCSCI-Controller für die Festplatte auf VMware PVSCSI ein.

- Erstellen Sie keine neue Festplatte (diese wird später von der ESXi-Quelle importiert).

- Jede VM erhält eine von Proxmox zugewiesene ID (notieren Sie diese, sie wird später benötigt).

VM von ESXi zu Proxmox kopieren

Der Inhalt der virtuellen Maschine (VM) wird vom ESXi- auf das Proxmox-System mithilfe des open source Tools rsync zur effizienten Synchronisierung und Kopie übertragen. Daher müssen die folgenden Befehle vom Proxmox-System aus ausgeführt werden, wo wir ein temporäres Verzeichnis zur Speicherung des VM-Inhalts erstellen:

mkdir /tmp/migration_pgsql07.gyptazy.ch cd /tmp/migration_pgsql07.gyptazy.ch rsync -avP root@esx02-test.gyptazy.ch:/vmfs/volumes/137b4261-68e88bae-0000-000000000000/pgsq07.gyptazy.ch/* .

Abhängig von der Dateigröße der virtuellen Maschine und der Netzwerkkonnektivität kann dieser Vorgang einige Zeit dauern.

VM in Proxmox importieren

Anschließend wird die Festplatte mit dem qm-Dienstprogramm importiert, wobei die VM-ID (die während des VM-Erstellungsprozesses erstellt wurde) definiert wird, sowie der Festplattenname (der kopiert wurde) und der Zieldatenspeicher auf dem Proxmox-System angegeben werden, wo die VM-Festplatte gespeichert werden soll:

Anschließend wird die Festplatte mit dem qm-Dienstprogramm importiert, wobei die VM-ID (die während des VM-Erstellungsprozesses erstellt wurde) definiert wird, sowie der Festplattenname (der kopiert wurde) und der Zieldatenspeicher auf dem Proxmox-System angegeben werden, wo die VM-Festplatte gespeichert werden soll:

qm disk import 119 pgsql07.gyptazy.ch.vmdk local-lvm

Abhängig vom Erstellungsformat der VM oder dem Exportformat kann es mehrere Festplattendateien geben, die auch mit _flat ergänzt werden können. Dieses Verfahren muss für alle verfügbaren Festplatten wiederholt werden.

VM starten

Im letzten Schritt sollten alle Einstellungen, Ressourcen, Definitionen und Anpassungen des Systems gründlich überprüft werden. Nach der Validierung kann die VM gestartet werden, um sicherzustellen, dass alle Komponenten für den Betrieb in der Proxmox-Umgebung korrekt konfiguriert sind.

Fazit

Dieser Artikel behandelt nur eine von vielen möglichen Methoden für Migrationen in einfachen, eigenständigen Setups. In komplexeren Umgebungen mit mehreren Host-Knoten und verschiedenen Speichersystemen wie Fibre Channel oder Netzwerkspeicher gibt es erhebliche Unterschiede und zusätzliche Überlegungen. Darüber hinaus kann es spezifische Anforderungen in Bezug auf Verfügbarkeit und Service Level Agreements (SLAs) geben, die zu berücksichtigen sind. Dies kann für jede Umgebung sehr spezifisch sein. Sie können sich jederzeit gerne an uns wenden, um eine persönliche Beratung zu Ihren spezifischen Migrationsanforderungen zu erhalten. Gerne bieten wir Ihnen auch unsere Unterstützung in verwandten Bereichen in open source wie Virtualisierung (z. B. OpenStack, VirtualBox) und Themen im Zusammenhang mit Cloud-Migrationen an.

Nachtrag

Am 27. März hat Proxmox seinen neuen Import-Assistenten (pve-esxi-import-tools) veröffentlicht, der Migrationen von VMware ESXi-Instanzen in eine Proxmox-Umgebung erheblich vereinfacht. In einem kommenden Blogbeitrag werden wir weitere Informationen zu den neuen Tools und Anwendungsfällen bereitstellen, in denen diese nützlicher sein könnten, aber auch die Randfälle behandeln, in denen der neue Import-Assistent nicht verwendet werden kann.

VXLAN steht für „Virtual eXtensible Local Area Network“. Standardisiert in RFC 7348 im August 2014 ist VXLAN heute auch als virtuelle Netzwerkschnittstelle in aktuellen Linuxkerneln verfügbar. Doch worum geht es bei VXLAN?

Worum geht es bei VXLAN?

Liest man die Stichworte „Virtual“ und „LAN“, denken die meisten zu Recht an VLAN. Hierbei wird ein großes physisches Netzwerk logisch in kleinere Netzwerke aufgeteilt. Dazu werden die entsprechenden Verbindungen mit VLAN-Tags markiert. Dies kann entweder beim sendenden Host (tagged VLAN) oder beispielsweise durch den Switch (portbasiertes VLAN) erfolgen. Diese Markierungen erfolgen bereits auf Layer 2, dem Data Link Layer im OSI Schichtenmodell. Hierdurch lassen sie sich bereits auf sehr niedriger Netzwerkebene sinnvoll auswerten und so unerwünschte Kommunikation im Netzwerk unterdrückt werden. Die Norm IEEE 802.1Q definiert für das VLAN-Tag 12 Bit Breite, somit ergeben sich grundsätzlich 4096 mögliche VLAN-Netzwerke auf einer Ethernet-Installation.

VXLAN wurde entwickelt, um diese Beschränkung zu umgehen. Mit VXLAN wird eine auf OSI-Layer 3 bzw. Layer 4 basierende Übertragungstechnik eingeführt, die virtuelle Layer-2-Umgebungen schafft. Mit der VXLAN-Logik sind rund 16 Millionen (2 hoch 24) VXLAN-Layer-2-Netzwerke möglich, die ihrerseits wieder 4096 VLAN-Netzwerkabschnitte abbilden können. Dies sollte zunächst auch für sehr große Ethernet-Installationen ausreichen.

Wie kann man ein solches VXLAN einrichten?

Eine VXLAN-Schnittstelle stellt man im Anschluss mit beispielsweise

ip link add vxlan0 type vxlan id 42 group 239.1.1.1 dev eth0

zur Verfügung. Dieses Kommando legt das Gerät „vxlan0“ als VXLAN mit der ID 42 auf dem physikalischen Interface „eth0“ an. Mehrere VXLAN werden auf Basis ihrer ID unterschieden. Die Anweisung „group <ip-adresse>“ legt die Übertragung auf Multicast und die zugehörige Multicast-Gruppe fest. Alternativ könnte hier auch mit dem Kommando „remote“ eine IP des Zielhostes auf Basis des zugrunde liegenden Netzwerkes (eth0) gegeben werden (Unicast-Betrieb). Mit weiteren Anweisungen lassen sich auch die Quell- und Zielports für die auf dem darunterliegenden IP-Netzwerkes auf „eth0“ festlegen. Standard nach IANA ist der UDP-Port 4789.

Mit der Befehlszeile

ip addr add 10.0.0.1/24 dev vxlan0

gibt man der neu erschaffenen VXLAN-Netzwerkschnittstelle eine feste IP-Adresse, hier im Beispiel 10.0.0.1

Der Befehl

ip link set up dev vxlan0

schaltet die neu angelegte Netzwerkschnittstelle „vxlan0“ scharf. Damit existiert ein virtuelles Netzwerk auf Basis von IP-Multicast auf dem physikalischen Interface „eth0“.

Das Interface „vxlan0“ verhält sich nun prinzipiell genauso wie eine Ethernet-Schnittstelle. Alle weiteren Rechner, die die VXLAN ID 42 und Multicast-Gruppe 239.1.1.1 auswählen, werden damit teil dieses virtuellen Ethernets. Auf diesem könnte man nun auch wieder verschiedene VLAN einrichten, beispielsweise mit

ip link add link vxlan0 name vlan1 type vlan id 1

ein neues VLAN auf der VXLAN-Schnittstelle aufsetzen. In diesem Falle bräuchte man der vxlan-Schnittstelle keine IP-Adresse zu geben.

Was lässt sich damit in der Praxis machen?

Grundsätzlich eignet sich VXLAN für den Einsatzfall, in einem sehr großen Ethernet, etwa in Cloud-Umgebungen, die Grenze von 4096 VLAN zu überwinden.

Einsatz als Testumgebung für Netzwerkdienste

Alternativ lässt sich VXLAN sehr gut in Testumgebungen oder virtualisierten Umgebungen einsetzen, in denen man die volle Kontrolle über das zu nutzende Layer-2-Netzwerk benötigt. Möchte man Netzwerkinfrastruktur-Komponenten bzw. deren Konfiguration testen, bietet sich ein solches, komplett isoliertes Netzwerk an. Auch kann man so von Virtualisierungsumgebungen eingefügte Kontrollstrukturen, die besonders für solche Tests hinderlich sind, umgehen. Mein erster Praxiskontakt zu VXLAN war beim Test eines komplexeren DHCP-Setups auf mehreren virtuellen Maschinen in OpenStack. Auf den vom OpenStack gelieferten Netzwerkschnittstellen war der Test für mich unmöglich, da ich zum einen nur beschränkten Zugriff auf die Netzwerkkonfigurationen auf Seite des Virtualisierungshosts hatte und OpenStack dhcp-Pakete aus dem Netzwerkstream ausfiltert. Dieses Problem ließ sich elegant durch Aufsetzen des Testnetzes auf VXLAN umgehen. Gleichzeitig war so sichergestellt, dass der DHCP-Test keinen Einfluss auf andere Teile des OpenStack-Netzes hatte. Außerdem blieb so die von OpenStack gelieferte Ethernet-Verbindung zu Wartungs- und Beobachtungszwecke dauerhaft nutzbar.

Es sind beispielsweise im Unicast-Betrieb auch Szenarien denkbar, bei denen ein über VXLAN aufgespanntes Layer-2-Netzwerk über mehrere Standorte transportiert wird. Es gibt Switches oder Router, die VXLAN unterstützen und als VTEP (VXLAN Tunnel Endpoints) dienen können. Diese setzt man beispielsweise ein, um zwei Multicast-VXLAN-Netzwerke per Unicast zwischen den VTEP zu verbinden und so transparent ein großes VXLAN aufspannen.

Ist VXLAN sicher?

VXLAN legt auf eine bestehende Ethernet-Infrastruktur eine weitere Layer-2-Infrastruktur. Diese arbeitet mit UDP-Paketen im Unicast oder Multicast. Eine Verschlüsselung auf VXLAN-Ebene ist nicht vorgesehen und müsste bei Bedarf über darüber liegende Protokollebenen geleistet werden. Hier kommen IPSec-Lösungen oder beispielsweise TLS in Frage. Grundsätzlich ist ein VXLAN auf einer vergleichbaren Sicherheitsebene wie die meisten anderen Netzwerkprotokolle auf Layer 2.

Mögliche Probleme?

Bei VXLAN kann möglicherweise dem Anwender ein „alter Bekannter“ in Form von MTU-Problemen wieder begegnen. Ein Standard-Ethernet-Frame hat eine Länge von 1.518 Bytes. Damit bleiben nach Abzug des Ethernet-Headers 1.500 Bytes für Nutzlast. VXLAN erweitert den Ethernet-Header um 50 Bytes, weshalb die verfügbare Nutzlast auf 1.450 Bytes sinkt. Dies sollte beim Setzen der MTU beachtet werden. Sogenannte Jumbo-Frames werden entsprechend beeinflusst. Hier sind die zusätzlichen 50 Bytes ebenfalls mit in Betracht zu ziehen.

Was bietet credativ?

Gerne unterstützen und beraten wir Sie bei der Gestaltung und Betrieb Ihrer Netzwerkumgebung. Wir arbeiten unter anderem im Bereich DevOps, Netzwerk-Infrastruktur und Netzwerkdesign. Die credativ GmbH verfügt über Mitarbeiter mit Expertise in hochkomplexen Netzwerksetups für Rechenzentren auf realer Hardware ebenso wie in virtueller Umgebung. Unser Schwerpunkt liegt auf der Umsetzung mit Open-Source-Software.

Aktuelle Virtualisierungs-Lösungen bieten die Möglichkeit, USB-Geräte an das Gast-System weiter zu reichen. KVM ist da keine Ausnahme, und ermöglicht so zum Beispiel die Weitergabe eines USB-GSM-Modems an einen KVM-Gast.

Nahezu jedes Unternehmen setzt heutzutage auf die Virtualisierung von Diensten. Häufig werden dabei nicht nur neue Systeme, sondern auch alte Dienste auf die virtualisierte Infrastruktur umgesattelt. Ein Kunde traf dabei auf das Problem, dass ein Dienst abhängig war von einem externen USB-GSM-Modem – dieses musste in der virtualisierten Umgebung an den Gast weiter gereicht werden. Der Kunde setzt für seine Virtualisierung auf KVM, und das bietet für diese Zwecke selbstverständnlich USB pass through.

Um USB pass through zu nutzen müssen auf dem KVM-Host die „vendor ID“ und die „product ID“ des USB-Geräts ausgelesen werden:

$ lsusb Bus 001 Device 001: ID 1d6b:0002 Linux Foundation 2.0 root hub Bus 002 Device 001: ID 1d6b:0002 Linux Foundation 2.0 root hub Bus 003 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub Bus 004 Device 002: ID 0557:2221 ATEN International Co., Ltd Winbond Hermon Bus 002 Device 003: ID 12d1:1003 Huawei Technologies Co., Ltd. E220 HSDPA Modem / E230/E270/E870 HSDPA/HSUPA Modem

Der letzte Eintrag zeigt das von Huawei hergestellte GSM-Modem. Die interessanten Ziffern ergeben sich aus den vierstelligen Nummern vor und nach dem Doppelpunkt: die „vendor ID“ ist 12d1, die product ID ist 1003.

Derzeit ist dies auf dem Gast-System noch nicht sichtbar. Dafür muss die Weiterreichung spezifiziert werden. Auf der Kommandozeile lässt sich dies mit dem „virsh“-Befehl umsetzen: $ sudo virsh edit example-server.

Dieses Programm öffnet die XML-Spezifikation des KVM-Gasts in einem Editor. Dort kann nun im Bereich „devices“ das USB-Gerät hinzugefügt werden:

[...]

<devices>

[...]

<hostdev mode='subsystem' type='usb' managed='no'>

<source>

<vendor id='0x12d1'/>

<product id='0x1003'/>

</source>

</hostdev>

</devices>Dabei muss darauf geachtet werden, dass den Nummern ein 0x beigefügt wird. Nachdem die Datei gespeichert und der KVM-Gast neugestartet wird – der KVM-Host braucht zum Glück dafür nicht neugestartet werden – kann auf dem Gast geprüft werden, ob das Gerät zu finden ist:

$ lsusb Bus 001 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub Bus 001 Device 002: ID 0627:0001 Adomax Technology Co., Ltd Bus 001 Device 003: ID 0409:55aa NEC Corp. Hub Bus 001 Device 004: ID 12d1:1003 Huawei Technologies Co., Ltd. E220 HSDPA Modem / E230/E270/E870 HSDPA/HSUPA Modem

Das Gerät taucht in der Übersicht des Gasts auf, und wird in diesem Fall auch direkt als Modem bereit gestellt:

USB Serial support registered for GSM modem (1-port) option 1-2.1:1.0: GSM modem (1-port) converter detected usb 1-2.1: GSM modem (1-port) converter now attached to ttyUSB0 option 1-2.1:1.1: GSM modem (1-port) converter detected usb 1-2.1: GSM modem (1-port) converter now attached to ttyUSB1 usbcore: registered new interface driver option option: v0.7.2:USB Driver for GSM modems

Damit ist das USB-GSM-Modem erfolgreich vom KVM-Host an den KVM-Gast übertragen worden.

Dieser Artikel wurde ursprünglich geschrieben von Roland Wolters.